_posts/2018-02-04-Idea-快捷键.md�����������������������������������������������������������������0000664�0001750�0001750�00000041531�14127043406�020027� 0����������������������������������������������������������������������������������������������������ustar �wangwen�������������������������wangwen����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������— layout: post title: IDEA快捷键使用 subtitle: 熟练使用IDEA快捷键,开发效率飞一般的感觉 date: 2018-02-04 author: AnAn header-img: /img/post-bg-article.jpg catalog: true tags: - IDEA快捷键 —

Debug 常用快捷键

| 快捷键 | 介绍 |

|---|---|

| F7 | 在 Debug 模式下,进入下一步,如果当前行断点是一个方法,则进入当前方法体内,如果该方法体还有方法,则不会进入该内嵌的方法中 必备 |

| F8 | 在 Debug 模式下,进入下一步,如果当前行断点是一个方法,则不进入当前方法体内 必备 |

| F9 | 在 Debug 模式下,恢复程序运行,但是如果该断点下面代码还有断点则停在下一个断点上 必备 |

| Alt + F8 | 在 Debug 的状态下,选中对象,弹出可输入计算表达式调试框,查看该输入内容的调试结果 必备 |

| Ctrl + F8 | 在 Debug 模式下,设置光标当前行为断点,如果当前已经是断点则去掉断点 |

| Shift + F7 | 在 Debug 模式下,智能步入。断点所在行上有多个方法调用,会弹出进入哪个方法 |

| Shift + F8 | 在 Debug 模式下,跳出,表现出来的效果跟 F9 一样 |

| Ctrl + Shift + F8 | 在 Debug 模式下,指定断点进入条件 |

| Alt + Shift + F7 | 在 Debug 模式下,进入下一步,如果当前行断点是一个方法,则进入当前方法体内,如果方法体还有方法,则会进入该内嵌的方法中,依此循环进入 |

| Drop Frame | 这个不是一个快捷键,而是一个 Debug 面板上的按钮。该按钮可以用来退回到当前停住的断点的上一层方法上,可以让过掉的断点重新来过 |

Ctrl

| 快捷键 | 介绍 |

|---|---|

| Ctrl + F | 在当前文件进行文本查找 (必备) |

| Ctrl + R | 在当前文件进行文本替换 (必备) |

| Ctrl + Z | 撤销 (必备) |

| Ctrl + Y | 删除光标所在行 或 删除选中的行 (必备) |

| Ctrl + X | 剪切光标所在行 或 剪切选择内容 |

| Ctrl + C | 复制光标所在行 或 复制选择内容 |

| Ctrl + D | 复制光标所在行 或 复制选择内容,并把复制内容插入光标位置下面 (必备) |

| Ctrl + W | 递进式选择代码块。可选中光标所在的单词或段落,连续按会在原有选中的基础上再扩展选中范围 (必备) |

| Ctrl + E | 显示最近打开的文件记录列表 (必备) |

| Ctrl + N | 根据输入的 类名 查找类文件 (必备) |

| Ctrl + G | 在当前文件跳转到指定行处 |

| Ctrl + J | 插入自定义动态代码模板 (必备) |

| Ctrl + P | 方法参数提示显示 (必备) |

| Ctrl + Q | 光标所在的变量 / 类名 / 方法名等上面(也可以在提示补充的时候按),显示文档内容 |

| Ctrl + U | 前往当前光标所在的方法的父类的方法 / 接口定义 (必备) |

| Ctrl + B | 进入光标所在的方法/变量的接口或是定义处,等效于 Ctrl + 左键单击 (必备) |

| Ctrl + K | 版本控制提交项目,需要此项目有加入到版本控制才可用 |

| Ctrl + T | 版本控制更新项目,需要此项目有加入到版本控制才可用 |

| Ctrl + H | 显示当前类的层次结构 |

| Ctrl + O | 选择可重写的方法 |

| Ctrl + I | 选择可继承的方法 |

| Ctrl + + | 展开代码 |

| Ctrl + - | 折叠代码 |

| Ctrl + / | 注释光标所在行代码,会根据当前不同文件类型使用不同的注释符号 (必备) |

| Ctrl + [ | 移动光标到当前所在代码的花括号开始位置 |

| Ctrl + ] | 移动光标到当前所在代码的花括号结束位置 |

| Ctrl + F1 | 在光标所在的错误代码处显示错误信息 (必备) |

| Ctrl + F3 | 调转到所选中的词的下一个引用位置 (必备) |

| Ctrl + F4 | 关闭当前编辑文件 |

| Ctrl + F8 | 在 Debug 模式下,设置光标当前行为断点,如果当前已经是断点则去掉断点 |

| Ctrl + F9 | 执行 Make Project 操作 |

| Ctrl + F11 | 选中文件 / 文件夹,使用助记符设定 / 取消书签 (必备) |

| Ctrl + F12 | 弹出当前文件结构层,可以在弹出的层上直接输入,进行筛选 |

| Ctrl + Tab | 编辑窗口切换,如果在切换的过程又加按上delete,则是关闭对应选中的窗口 |

| Ctrl + End | 跳到文件尾 |

| Ctrl + Home | 跳到文件头 |

| Ctrl + Space | 基础代码补全,默认在 Windows 系统上被输入法占用,需要进行修改,建议修改为 Ctrl + 逗号 (必备) |

| Ctrl + Delete | 删除光标后面的单词或是中文句 (必备) |

| Ctrl + BackSpace | 删除光标前面的单词或是中文句 (必备) |

| Ctrl + 1,2,3…9 | 定位到对应数值的书签位置 (必备) |

| Ctrl + 左键单击 | 在打开的文件标题上,弹出该文件路径 (必备) |

| Ctrl + 光标定位 | 按 Ctrl 不要松开,会显示光标所在的类信息摘要 |

| Ctrl + 左方向键 | 光标跳转到当前单词 / 中文句的左侧开头位置 (必备) |

| Ctrl + 右方向键 | 光标跳转到当前单词 / 中文句的右侧开头位置 (必备) |

| Ctrl + 前方向键 | 等效于鼠标滚轮向前效果 (必备) |

| Ctrl + 后方向键 | 等效于鼠标滚轮向后效果 (必备) |

Alt

| 快捷键 | 介绍 |

|---|---|

| Alt + ` | 显示版本控制常用操作菜单弹出层 (必备) |

| Alt + Q | 弹出一个提示,显示当前类的声明 / 上下文信息 |

| Alt + F1 | 显示当前文件选择目标弹出层,弹出层中有很多目标可以进行选择 (必备) |

| Alt + F2 | 对于前面页面,显示各类浏览器打开目标选择弹出层 |

| Alt + F3 | 选中文本,逐个往下查找相同文本,并高亮显示 |

| Alt + F7 | 查找光标所在的方法 / 变量 / 类被调用的地方 |

| Alt + F8 | 在 Debug 的状态下,选中对象,弹出可输入计算表达式调试框,查看该输入内容的调试结果 |

| Alt + Home | 定位 / 显示到当前文件的 Navigation Bar |

| Alt + Enter | IntelliJ IDEA 根据光标所在问题,提供快速修复选择,光标放在的位置不同提示的结果也不同 (必备) |

| Alt + Insert | 代码自动生成,如生成对象的 set / get 方法,构造函数,toString() 等 (必备) |

| Alt + 左方向键 | 切换当前已打开的窗口中的子视图,比如Debug窗口中有Output、Debugger等子视图,用此快捷键就可以在子视图中切换 (必备) |

| Alt + 右方向键 | 按切换当前已打开的窗口中的子视图,比如Debug窗口中有Output、Debugger等子视图,用此快捷键就可以在子视图中切换 (必备) |

| Alt + 前方向键 | 当前光标跳转到当前文件的前一个方法名位置 (必备) |

| Alt + 后方向键 | 当前光标跳转到当前文件的后一个方法名位置 (必备) |

| Alt +1,2,3…9 | 显示对应数值的选项卡,其中 1 是 Project 用得最多 (必备) |

Shift

| 快捷键 | 介绍 |

|---|---|

| Shift + F1 | 如果有外部文档可以连接外部文档 |

| Shift + F2 | 跳转到上一个高亮错误 或 警告位置 |

| Shift + F3 | 在查找模式下,查找匹配上一个 |

| Shift + F4 | 对当前打开的文件,使用新Windows窗口打开,旧窗口保留 |

| Shift + F6 | 对文件 / 文件夹 重命名 |

| Shift + F7 | 在 Debug 模式下,智能步入。断点所在行上有多个方法调用,会弹出进入哪个方法 |

| Shift + F8 | 在 Debug 模式下,跳出,表现出来的效果跟 F9 一样 |

| Shift + F9 | 等效于点击工具栏的 Debug 按钮 |

| Shift + F10 | 等效于点击工具栏的 Run 按钮 |

| Shift + F11 | 弹出书签显示层 (必备) |

| Shift + Tab | 取消缩进 (必备) |

| Shift + ESC | 隐藏当前 或 最后一个激活的工具窗口 |

| Shift + End | 选中光标到当前行尾位置 |

| Shift + Home | 选中光标到当前行头位置 |

| Shift + Enter | 开始新一行。光标所在行下空出一行,光标定位到新行位置 (必备) |

| Shift + 左键单击 | 在打开的文件名上按此快捷键,可以关闭当前打开文件 (必备) |

| Shift + 滚轮前后滚动 | 当前文件的横向滚动轴滚动 (必备) |

Ctrl + Alt

| 快捷键 | 介绍 |

|---|---|

| Ctrl + Alt + L | 格式化代码,可以对当前文件和整个包目录使用 (必备) |

| Ctrl + Alt + O | 优化导入的类,可以对当前文件和整个包目录使用 (必备) |

| Ctrl + Alt + I | 光标所在行 或 选中部分进行自动代码缩进,有点类似格式化 |

| Ctrl + Alt + T | 对选中的代码弹出环绕选项弹出层 (必备) |

| Ctrl + Alt + J | 弹出模板选择窗口,将选定的代码加入动态模板中 |

| Ctrl + Alt + H | 调用层次 |

| Ctrl + Alt + B | 在某个调用的方法名上使用会跳到具体的实现处,可以跳过接口 |

| Ctrl + Alt + C | 重构-快速提取常量 |

| Ctrl + Alt + F | 重构-快速提取成员变量 |

| Ctrl + Alt + V | 重构-快速提取变量 |

| Ctrl + Alt + Y | 同步、刷新 |

| Ctrl + Alt + S | 打开 IntelliJ IDEA 系统设置 (必备) |

| Ctrl + Alt + F7 | 显示使用的地方。寻找被该类或是变量被调用的地方,用弹出框的方式找出来 |

| Ctrl + Alt + F11 | 切换全屏模式 |

| Ctrl + Alt + Enter | 光标所在行上空出一行,光标定位到新行 (必备) |

| Ctrl + Alt + Home | 弹出跟当前文件有关联的文件弹出层 |

| Ctrl + Alt + Space | 类名自动完成 |

| Ctrl + Alt + 左方向键 | 退回到上一个操作的地方 (必备) |

| Ctrl + Alt + 右方向键 | 前进到上一个操作的地方 (必备) |

| Ctrl + Alt + 前方向键 | 在查找模式下,跳到上个查找的文件 |

| Ctrl + Alt + 后方向键 | 在查找模式下,跳到下个查找的文件 |

| Ctrl + Alt + 右括号(]) | 在打开多个项目的情况下,切换下一个项目窗口 |

| Ctrl + Alt + 左括号([) | 在打开多个项目的情况下,切换上一个项目窗口 |

Ctrl + Shift

| 快捷键 | 介绍 |

|---|---|

| Ctrl + Shift + F | 根据输入内容查找整个项目 或 指定目录内文件 (必备) |

| Ctrl + Shift + R | 根据输入内容替换对应内容,范围为整个项目 或 指定目录内文件 (必备) |

| Ctrl + Shift + J | 自动将下一行合并到当前行末尾 (必备) |

| Ctrl + Shift + Z | 取消撤销 (必备) |

| Ctrl + Shift + W | 递进式取消选择代码块。可选中光标所在的单词或段落,连续按会在原有选中的基础上再扩展取消选中范围(必备) |

| Ctrl + Shift + N | 通过文件名定位 / 打开文件 / 目录,打开目录需要在输入的内容后面多加一个正斜杠 (必备) |

| Ctrl + Shift + U | 对选中的代码进行大 / 小写轮流转换 (必备) |

| Ctrl + Shift + T | 对当前类生成单元测试类,如果已经存在的单元测试类则可以进行选择 (必备) |

| Ctrl + Shift + C | 复制当前文件磁盘路径到剪贴板 (必备) |

| Ctrl + Shift + V | 弹出缓存的最近拷贝的内容管理器弹出层 |

| Ctrl + Shift + E | 显示最近修改的文件列表的弹出层 |

| Ctrl + Shift + H | 显示方法层次结构 |

| Ctrl + Shift + B | 跳转到类型声明处 (必备) |

| Ctrl + Shift + I | 快速查看光标所在的方法 或 类的定义 |

| Ctrl + Shift + A | 查找动作 / 设置 |

| Ctrl + Shift + / | 代码块注释 (必备) |

| Ctrl + Shift + [ | 选中从光标所在位置到它的顶部中括号位置 (必备) |

| Ctrl + Shift + ] | 选中从光标所在位置到它的底部中括号位置 (必备) |

| Ctrl + Shift + + | 展开所有代码 (必备) |

| Ctrl + Shift + - | 折叠所有代码 (必备) |

| Ctrl + Shift + F7 | 高亮显示所有该选中文本,按Esc高亮消失 (必备) |

| Ctrl + Shift + F8 | 在 Debug 模式下,指定断点进入条件 |

| Ctrl + Shift + F9 | 编译选中的文件 / 包 / Module |

| Ctrl + Shift + F12 | 编辑器最大化 (必备) |

| Ctrl + Shift + Space | 智能代码提示 |

| Ctrl + Shift + Enter | 自动结束代码,行末自动添加分号 (必备) |

| Ctrl + Shift + Backspace | 退回到上次修改的地方 (必备) |

| Ctrl + Shift + 1,2,3…9 | 快速添加指定数值的书签 (必备) |

| Ctrl + Shift + 左键单击 | 把光标放在某个类变量上,按此快捷键可以直接定位到该类中 (必备) |

| Ctrl + Shift + 左方向键 | 在代码文件上,光标跳转到当前单词 / 中文句的左侧开头位置,同时选中该单词 / 中文句 (必备) |

| Ctrl + Shift + 右方向键 | 在代码文件上,光标跳转到当前单词 / 中文句的右侧开头位置,同时选中该单词 / 中文句 (必备) |

| Ctrl + Shift + 前方向键 | 光标放在方法名上,将方法移动到上一个方法前面,调整方法排序 (必备) |

| Ctrl + Shift + 后方向键 | 光标放在方法名上,将方法移动到下一个方法前面,调整方法排序 (必备) |

Alt + Shift

| 快捷键 | 介绍 |

|---|---|

| Alt + Shift + N | 选择 / 添加 task (必备) |

| Alt + Shift + F | 显示添加到收藏夹弹出层 / 添加到收藏夹 |

| Alt + Shift + C | 查看最近操作项目的变化情况列表 |

| Alt + Shift + I | 查看项目当前文件 |

| Alt + Shift + F7 | 在 Debug 模式下,下一步,进入当前方法体内,如果方法体还有方法,则会进入该内嵌的方法中,依此循环进入 |

| Alt + Shift + F9 | 弹出 Debug 的可选择菜单 |

| Alt + Shift + F10 | 弹出 Run 的可选择菜单 |

| Alt + Shift + 左键双击 | 选择被双击的单词 / 中文句,按住不放,可以同时选择其他单词 / 中文句 (必备) |

| Alt + Shift + 前方向键 | 移动光标所在行向上移动 (必备) |

| Alt + Shift + 后方向键 | 移动光标所在行向下移动 (必备) |

Ctrl + Shift + Alt

| 快捷键 | 介绍 |

|---|---|

| Ctrl + Shift + Alt + V | 无格式黏贴 (必备) |

| Ctrl + Shift + Alt + N | 前往指定的变量 / 方法 |

| Ctrl + Shift + Alt + S | 打开当前项目设置 (必备) |

| Ctrl + Shift + Alt + C | 复制参考信息 |

其他

| 快捷键 | 介绍 |

|---|---|

| F2 | 跳转到下一个高亮错误 或 警告位置 (必备) |

| F3 | 在查找模式下,定位到下一个匹配处 |

| F4 | 编辑源 (必备) |

| F7 | 在 Debug 模式下,进入下一步,如果当前行断点是一个方法,则进入当前方法体内,如果该方法体还有方法,则不会进入该内嵌的方法中 |

| F8 | 在 Debug 模式下,进入下一步,如果当前行断点是一个方法,则不进入当前方法体内 |

| F9 | 在 Debug 模式下,恢复程序运行,但是如果该断点下面代码还有断点则停在下一个断点上 |

| F11 | 添加书签 (必备) |

| F12 | 回到前一个工具窗口 (必备) |

| Tab | 缩进 (必备) |

| ESC | 从工具窗口进入代码文件窗口 (必备) |

| 连按两次Shift | 弹出 Search Everywhere 弹出层 |

| 功能 | 快捷键 | 功能描述 |

|---|---|---|

| Enter Full Screen | Alt+F | 隐藏桌面的任务栏和编译器顶部的窗体 |

| Enter Presentation Mode | Alt+D | 无扰模式,很高端的效果 |

| Tool Buttons | Alt+T | 隐藏/显示工具按钮栏 |

| Status Bar | Alt+S | 隐藏/显示状态栏 |

| start ssh session | Ctrl + Alt + Shift + O | 打开SSH会话连接 |

| 快捷键 | 功能 |

|---|---|

| Ctrl + Y | 删除一行 |

| Ctrl + W | 选中代码,连续按会有其他效果 |

| Ctrl + Z | 撤销操作 |

| Ctrl + Shift + Z | 恢复Ctrl+Z撤销的操作 |

| Alt + Enter | 引入类或提供给你选择的处理方法 |

| Alt/Ctrl + Shift + 上下 | 代码向上/下移动一行 |

| Alt + / | 复制上一个单词 |

| Alt + Shift + Enter | 自动补全分号 |

| Alt + Shift + V | 粘贴板历史 |

| Ctrl + F | 在本文件查找,可通过方向键移动选择(按Esc消失) |

| Ctrl + Shift + F | 在制定路径/模块/工程内查找 非常常用的一个功能,很多时候你想查找一个内容但是不一定知道它在哪里,这个就很实用 |

| Ctrl + R | 在本文件内查找/替换(按Esc消失) |

| Ctrl + N | 在本工程类查询某个类 |

| Ctrl + Shift + N | 查询某个类(不限本工程) 看源码很实用,比如我想看看jdk里面TreeMap这个类的代码,就可以用这个功能 |

快捷键 | 功能 — | — Ctrl + H | 查看一个类的继承关系 Ctrl + B | 查看一个类或者变量的申明 Alt + F7 | 查找一个属性或方法被谁调用 Alt + 上下 | 跳到上/下一个方法(或属性) Ctrl + 上下 | 上下滑屏但是不移动光标 Alt + 左右 | 同时打开多个文件时切换代码视图 Ctrl + Alt + 左右 | 返回至上次浏览的位置 非常实用,在多个文件代码中遨游的时候能够快速回到想去的位置 Ctrl + 上下 | 光标跳转到第一行或最后一行 Alt + Shift + C | 最近修改的代码 Ctrl + Q | 显示注释文档 Ctrl + P | 查看函数参数 Ctrl + J | 代码模板 Alt + Delete | 安全删除字段或方法 Ctrl + Alt + N | 去除一些多余的赋值过程或者函数 Shift + F6 | 重命名类或者变量 Alt + F12 | 打开命令行终端 Alt + 1 | 打开工程结构 Alt + 7 | 打开类结构 Alt + 9 | 打开change �����������������������������������������������������������������������������������������������������������������������������������������������������������������������_posts/2018-02-06-Linux-常用命令.md�������������������������������������������������������������0000664�0001750�0001750�00000043063�13763566257�021425� 0����������������������������������������������������������������������������������������������������ustar �wangwen�������������������������wangwen����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������— layout: post title: Linux常用命令 subtitle: Bash 常用命令 date: 2018-02-06 author: AnAn header-img: /img/post-bg-article.jpg catalog: true tags: - Linux —

Bash 常用命令

基础常用命令

某个命令 --h,对这个命令进行解释某个命令 --help,解释这个命令(更详细)man某个命令,文档式解释这个命令(更更详细)(执行该命令后,还可以按/+关键字进行查询结果的搜索)Ctrl + c,结束命令TAB键,自动补全命令(按一次自动补全,连续按两次,提示所有以输入开头字母的所有命令)键盘上下键,输入临近的历史命令history,查看所有的历史命令Ctrl + r,进入历史命令的搜索功能模式clear,清除屏幕里面的所有命令pwd,显示当前目录路径(常用)firefox&,最后后面的 & 符号,表示使用后台方式打开 Firefox,然后显示该进程的 PID 值jobs,查看后台运行的程序列表ifconfig,查看内网 IP 等信息(常用)curl ifconfig.me,查看外网 IP 信息curl ip.cn,查看外网 IP 信息locate 搜索关键字,快速搜索系统文件/文件夹(类似 Windows 上的 everything 索引式搜索)(常用)updatedb,配合上面的 locate,给 locate 的索引更新(locate 默认是一天更新一次索引)(常用)

date,查看系统时间(常用)date -s20080103,设置日期(常用)date -s18:24,设置时间,如果要同时更改 BIOS 时间,再执行hwclock --systohc(常用)

cal,在终端中查看日历,肯定没有农历显示的uptime,查看系统已经运行了多久,当前有几个用户等信息(常用)cat 文件路名,显示文件内容(属于打印语句)cat -n 文件名,显示文件,并每一行内容都编号more 文件名,用分页的方式查看文件内容(按 space 翻下一页,按 Ctrl + B 返回上页)less文件名,用分页的方式查看文件内容(带上下翻页)- 按 j 向下移动,按 k 向上移动

- 按 / 后,输入要查找的字符串内容,可以对文件进行向下查询,如果存在多个结果可以按 n 调到下一个结果出

- 按 ? 后,输入要查找的字符串内容,可以对文件进行向上查询,如果存在多个结果可以按 n 调到下一个结果出

shutdownshutdown -hnow,立即关机shutdown -h+10,10 分钟后关机shutdown -h23:30,23:30 关机shutdown -rnew,立即重启

poweroff,立即关机(常用)reboot,立即重启(常用)zip mytest.zip /opt/test/,把 /opt 目录下的 test/ 目录进行压缩,压缩成一个名叫 mytest 的 zip 文件unzip mytest.zip,对 mytest.zip 这个文件进行解压,解压到当前所在目录unzip mytest.zip -d /opt/setups/,对 mytest.zip 这个文件进行解压,解压到 /opt/setups/ 目录下

tar -cvf mytest.tar mytest/,对 mytest/ 目录进行归档处理(归档和压缩不一样)tar -xvf mytest.tar,释放 mytest.tar 这个归档文件,释放到当前目录tar -xvf mytest.tar -C /opt/setups/,释放 mytest.tar 这个归档文件,释放到 /opt/setups/ 目录下

last,显示最近登录的帐户及时间lastlog,显示系统所有用户各自在最近登录的记录,如果没有登录过的用户会显示 从未登陆过ls,列出当前目录下的所有没有隐藏的文件 / 文件夹。ls -a,列出包括以.号开头的隐藏文件 / 文件夹(也就是所有文件)ls -R,显示出目录下以及其所有子目录的文件 / 文件夹(递归地方式,不显示隐藏的文件)ls -a -R,显示出目录下以及其所有子目录的文件 / 文件夹(递归地方式,显示隐藏的文件)ls -al,列出目录下所有文件(包含隐藏)的权限、所有者、文件大小、修改时间及名称(也就是显示详细信息)ls -ld 目录名,显示该目录的基本信息ls -t,依照文件最后修改时间的顺序列出文件名。ls -F,列出当前目录下的文件名及其类型。以 / 结尾表示为目录名,以 * 结尾表示为可执行文件,以 @ 结尾表示为符号连接ls -lg,同上,并显示出文件的所有者工作组名。ls -lh,查看文件夹类文件详细信息,文件大小,文件修改时间ls /opt | head -5,显示 opt 目录下前 5 条记录ls -l | grep '.jar',查找当前目录下所有 jar 文件ls -l /opt |grep "^-"|wc -l,统计 opt 目录下文件的个数,不会递归统计ls -lR /opt |grep "^-"|wc -l,统计 opt 目录下文件的个数,会递归统计ls -l /opt |grep "^d"|wc -l,统计 opt 目录下目录的个数,不会递归统计ls -lR /opt |grep "^d"|wc -l,统计 opt 目录下目录的个数,会递归统计ls -lR /opt |grep "js"|wc -l,统计 opt 目录下 js 文件的个数,会递归统计ls -l,列出目录下所有文件的权限、所有者、文件大小、修改时间及名称(也就是显示详细信息,不显示隐藏文件)。显示出来的效果如下:-rwxr-xr-x. 1 root root 4096 3月 26 10:57 其中最前面的 - 表示这是一个普通文件 lrwxrwxrwx. 1 root root 4096 3月 26 10:57 其中最前面的 l 表示这是一个链接文件 类似 Windows 的快捷方式 drwxr-xr-x. 5 root root 4096 3月 26 10:57 其中最前面的 d 表示这是一个目录

cd,目录切换cd ..,改变目录位置至当前目录的父目录(上级目录)。cd ~,改变目录位置至用户登录时的工作目录。cd 回车,回到家目录cd -,上一个工作目录cd dir1/,改变目录位置至 dir1 目录下。cd ~user,改变目录位置至用户的工作目录。cd ../user,改变目录位置至相对路径user的目录下。cd /../..,改变目录位置至绝对路径的目录位置下。

cp 源文件 目标文件,复制文件cp -r 源文件夹 目标文件夹,复制文件夹cp -r -v 源文件夹 目标文件夹,复制文件夹(显示详细信息,一般用于文件夹很大,需要查看复制进度的时候)cp /usr/share/easy-rsa/2.0/keys/{ca.crt,server.{crt,key},dh2048.pem,ta.key} /etc/openvpn/keys/,复制同目录下花括号中的文件

tar cpf - . | tar xpf - -C /opt,复制当前所有文件到 /opt 目录下,一般如果文件夹文件多的情况下用这个更好,用 cp 比较容易出问题mv 文件 目标文件夹,移动文件到目标文件夹mv 文件,不指定目录重命名后的名字,用来重命名文件

touch 文件名,创建一个空白文件/更新已有文件的时间(后者少用)mkdir 文件夹名,创建文件夹mkdir -p /opt/setups/nginx/conf/,创建一个名为 conf 文件夹,如果它的上级目录 nginx 没有也会跟着一起生成,如果有则跳过rmdir 文件夹名,删除文件夹(只能删除文件夹里面是没有东西的文件夹)rm 文件,删除文件rm -r 文件夹,删除文件夹rm -r -i 文件夹,在删除文件夹里的文件会提示(要的话,在提示后面输入yes)rm -r -f 文件夹,强制删除rm -r -f 文件夹1/ 文件夹2/ 文件夹3/删除多个

find,高级查找find . -name *lin*,其中 . 代表在当前目录找,-name 表示匹配文件名 / 文件夹名,*lin* 用通配符搜索含有lin的文件或是文件夹find . -iname *lin*,其中 . 代表在当前目录找,-iname 表示匹配文件名 / 文件夹名(忽略大小写差异),*lin* 用通配符搜索含有lin的文件或是文件夹find / -name *.conf,其中 / 代表根目录查找,*.conf代表搜索后缀会.conf的文件find /opt -name .oh-my-zsh,其中 /opt 代表目录名,.oh-my-zsh 代表搜索的是隐藏文件 / 文件夹名字为 oh-my-zsh 的find /opt -type f -iname .oh-my-zsh,其中 /opt 代表目录名,-type f 代表只找文件,.oh-my-zsh 代表搜索的是隐藏文件名字为 oh-my-zsh 的find /opt -type d -iname .oh-my-zsh,其中 /opt 代表目录名,-type d 代表只找目录,.oh-my-zsh 代表搜索的是隐藏文件夹名字为 oh-my-zsh 的find . -name "lin*" -exec ls -l {} \;,当前目录搜索lin开头的文件,然后用其搜索后的结果集,再执行ls -l的命令(这个命令可变,其他命令也可以),其中 -exec 和 {} \; 都是固定格式find /opt -type f -size +800M -print0 | xargs -0 du -h | sort -nr,找出 /opt 目录下大于 800 M 的文件find / -name "*tower*" -exec rm {} \;,找到文件并删除find / -name "*tower*" -exec mv {} /opt \;,找到文件并移到 opt 目录find . -name "*" |xargs grep "youmeek",递归查找当前文件夹下所有文件内容中包含 youmeek 的文件find . -size 0 | xargs rm -f &,删除当前目录下文件大小为0的文件du -hm --max-depth=2 | sort -nr | head -12,找出系统中占用容量最大的前 12 个目录

cat /etc/resolv.conf,查看 DNS 设置netstat -tlunp,查看当前运行的服务,同时可以查看到:运行的程序已使用端口情况env,查看所有系统变量export,查看所有系统变量echoecho $JAVA_HOME,查看指定系统变量的值,这里查看的是自己配置的 JAVA_HOME。echo "字符串内容",输出 “字符串内容”echo > aa.txt,清空 aa.txt 文件内容(类似的还有:: > aa.txt,其中 : 是一个占位符, 不产生任何输出)

unset $JAVA_HOME,删除指定的环境变量ln -s /opt/data /opt/logs/data,表示给 /opt/logs 目录下创建一个名为 data 的软链接,该软链接指向到 /opt/datagrepshell grep -H '安装' *.sh,查找当前目录下所有 sh 类型文件中,文件内容包含安装的当前行内容grep 'test' java*,显示当前目录下所有以 java 开头的文件中包含 test 的行grep 'test' spring.ini docker.sh,显示当前目录下 spring.ini docker.sh 两个文件中匹配 test 的行

psps –ef|grep java,查看当前系统中有关 java 的所有进程ps -ef|grep --color java,高亮显示当前系统中有关 java 的所有进程

killkill 1234,结束 pid 为 1234 的进程kill -9 1234,强制结束 pid 为 1234 的进程(慎重)killall java,结束同一进程组内的所有为 java 进程ps -ef|grep hadoop|grep -v grep|cut -c 9-15|xargs kill -9,结束包含关键字 hadoop 的所有进程

headhead -n 10 spring.ini,查看当前文件的前 10 行内容

tailtail -n 10 spring.ini,查看当前文件的后 10 行内容tail -200f 文件名,查看文件被更新的新内容尾 200 行,如果文件还有在新增可以动态查看到(一般用于查看日记文件)

用户、权限-相关命令

- 使用 pem 证书登录:

ssh -i /opt/mykey.pem root@192.168.0.70- 证书权限不能太大,不然无法使用:

chmod 600 mykey.pem

- 证书权限不能太大,不然无法使用:

hostname,查看当前登陆用户全名cat /etc/group,查看所有组cat /etc/passwd,查看所有用户groups youmeek,查看 youmeek 用户属于哪个组useradd youmeek -g judasn,添加用户并绑定到 judasn 组下userdel -r youmeek,删除名字为 youmeek 的用户- 参数:

-r,表示删除用户的时候连同用户的家目录一起删除

- 参数:

- 修改普通用户 youmeek 的权限跟 root 权限一样:

- 常用方法(原理是把该用户加到可以直接使用 sudo 的一个权限状态而已):

- 编辑配置文件:

vim /etc/sudoers - 找到 98 行(预估),有一个:

root ALL=(ALL) ALL,在这一行下面再增加一行,效果如下:

root ALL=(ALL) ALL youmeek ALL=(ALL) ALL - 编辑配置文件:

- 另一种方法:

- 编辑系统用户的配置文件:

vim /etc/passwd,找到 root 和 youmeek 各自开头的那一行,比如 root 是:root:x:0:0:root:/root:/bin/zsh,这个代表的含义为:用户名:密码:UserId:GroupId:描述:家目录:登录使用的 shell - 通过这两行对比,我们可以直接修改 youmeek 所在行的 UserId 值 和 GroupId 值,都改为 0。

- 编辑系统用户的配置文件:

- 常用方法(原理是把该用户加到可以直接使用 sudo 的一个权限状态而已):

groupadd judasn,添加一个名为 judasn 的用户组groupdel judasn,删除一个名为 judasn 的用户组(前提:先删除组下面的所有用户)usermod 用户名 -g 组名,把用户修改到其他组下passwd youmeek,修改 youmeek 用户的密码(前提:只有 root 用户才有修改其他用户的权限,其他用户只能修改自己的)chmod 777 文件名/目录,给指定文件增加最高权限,系统中的所有人都可以进行读写。- linux 的权限分为 rwx。r 代表:可读,w 代表:可写,x 代表:可执行

- 这三个权限都可以转换成数值表示,r = 4,w = 2,x = 1,- = 0,所以总和是 7,也就是最大权限。第一个 7 是所属主(user)的权限,第二个 7 是所属组(group)的权限,最后一位 7 是非本群组用户(others)的权限。

chmod -R 777 目录表示递归目录下的所有文件夹,都赋予 777 权限

su:切换到 root 用户,终端目录还是原来的地方(常用)su -:切换到 root 用户,其中 - 号另起一个终端并切换账号su 用户名,切换指定用户帐号登陆,终端目录还是原来地方。su - 用户名,切换到指定用户帐号登陆,其中 - 号另起一个终端并切换账号

exit,注销当前用户(常用)sudo 某个命令,使用管理员权限使用命令,使用 sudo 回车之后需要输入当前登录账号的密码。(常用)passwd,修改当前用户密码(常用)- 添加临时账号,并指定用户根目录,并只有可读权限方法

- 添加账号并指定根目录(用户名 tempuser):

useradd -d /data/logs -m tempuser - 设置密码:

passwd tempuser回车设置密码 - 删除用户(该用户必须退出 SSH 才能删除成功),也会同时删除组:

userdel tempuser

- 添加账号并指定根目录(用户名 tempuser):

磁盘管理

df -h,自动以合适的磁盘容量单位查看磁盘大小和使用空间df -k,以磁盘容量单位 K 为数值结果查看磁盘使用情况df -m,以磁盘容量单位 M 为数值结果查看磁盘使用情况

du -sh /opt,查看 opt 这个文件夹大小 (h 的意思 human-readable 用人类可读性较好方式显示,系统会自动调节单位,显示合适大小的单位)du -sh ./*,查看当前目录下所有文件夹大小 (h 的意思 human-readable 用人类可读性较好方式显示,系统会自动调节单位,显示合适大小的单位)du -sh /opt/setups/,显示 /opt/setups/ 目录所占硬盘空间大小(s 表示 –summarize 仅显示总计,即当前目录的大小。h 表示 –human-readable 以 KB,MB,GB 为单位,提高信息的可读性)mount /dev/sdb5 /newDir/,把分区 sdb5 挂载在根目录下的一个名为 newDir 的空目录下,需要注意的是:这个目录最好为空,不然已有的那些文件将看不到,除非卸载挂载。- 挂载好之后,通过:

df -h,查看挂载情况。

- 挂载好之后,通过:

umount /newDir/,卸载挂载,用目录名- 如果这样卸载不了可以使用:

umount -l /newDir/

- 如果这样卸载不了可以使用:

umount /dev/sdb5,卸载挂载,用分区名

wget 下载文件

- 常规下载:

wget http://www.gitnavi.com/index.html - 自动断点下载:

wget -c http://www.gitnavi.com/index.html - 后台下载:

wget -b http://www.gitnavi.com/index.html - 伪装代理名称下载:

wget --user-agent="Mozilla/5.0 (Windows; U; Windows NT 6.1; en-US) AppleWebKit/534.16 (KHTML, like Gecko) Chrome/10.0.648.204 Safari/534.16" http://www.gitnavi.com/index.html - 限速下载:

wget --limit-rate=300k http://www.gitnavi.com/index.html - 批量下载:

wget -i /opt/download.txt,一个下载地址一行 - 后台批量下载:

wget -b -c -i /opt/download.txt,一个下载地址一行

其他常用命令

- 编辑 hosts 文件:

vim /etc/hosts,添加内容格式:127.0.0.1 www.youmeek.com - RPM 文件操作命令:

- 安装

rpm -i example.rpm,安装 example.rpm 包rpm -iv example.rpm,安装 example.rpm 包并在安装过程中显示正在安装的文件信息rpm -ivh example.rpm,安装 example.rpm 包并在安装过程中显示正在安装的文件信息及安装进度

- 查询

rpm -qa | grep jdk,查看 jdk 是否被安装rpm -ql jdk,查看 jdk 是否被安装

- 卸载

rpm -e jdk,卸载 jdk(一般卸载的时候都要先用 rpm -qa 看下整个软件的全名)

- 安装

- YUM 软件管理:

yum install -y httpd,安装 apacheyum remove -y httpd,卸载 apacheyum info -y httpd,查看 apache 版本信息yum list --showduplicates httpd,查看可以安装的版本yum install httpd-查询到的版本号,安装指定版本- 更多命令可以看:http://man.linuxde.net/yum

- 查看某个配置文件,排除掉里面以 # 开头的注释内容:

grep '^[^#]' /etc/openvpn/server.conf

- 查看某个配置文件,排除掉里面以 # 开头和 ; 开头的注释内容:

grep '^[^#;]' /etc/openvpn/server.conf

资料

- http://wenku.baidu.com/view/1ad19bd226fff705cc170af3.html

- http://blog.csdn.net/nzing/article/details/9166057

- http://linuxtools-rst.readthedocs.io/zh_CN/latest/tool/wget.html

- https://www.jianshu.com/p/180fb11a5b96

�����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������_posts/2018-03-03-Git-飞行指南.md���������������������������������������������������������������0000664�0001750�0001750�00000126372�14125045722�020555� 0����������������������������������������������������������������������������������������������������ustar �wangwen�������������������������wangwen����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������—

layout: post

title: Git飞行规则(Flight Rules)

subtitle: 这是一篇给宇航员(这里就是指使用Git的程序员们)的指南,用来指导问题出现后的应对之法。

date: 2018-03-03

author: 转载,出处不详

header-img: /img/post-bg-article.jpg

catalog: true

tags:

-

Git

-

Git飞行规则(Flight Rules)

前言

- 英文原版README

什么是”飞行规则”?

这是一篇给宇航员(这里就是指使用Git的程序员们)的指南,用来指导问题出现后的应对之法。

飞行规则(Flight Rules) 是记录在手册上的来之不易的一系列知识,记录了某个事情发生的原因,以及怎样一步一步的进行处理。本质上, 它们是特定场景的非常详细的标准处理流程。 […]

自20世纪60年代初以来,NASA一直在捕捉(capturing)我们的失误,灾难和解决方案, 当时水星时代(Mercury-era)的地面小组首先开始将“经验教训”收集到一个纲要(compendium)中,该纲现在已经有上千个问题情景,从发动机故障到破损的舱口把手到计算机故障,以及它们对应的解决方案。

— Chris Hadfield, 一个宇航员的生活指南(An Astronaut’s Guide to Life)。

这篇文章的约定

为了清楚的表述,这篇文档里的所有例子使用了自定义的bash 提示,以便指示当前分支和是否有暂存的变化(changes)。分支名用小括号括起来,分支名后面跟的*表示暂存的变化(changes)。

- 编辑提交(editting commits)

- 暂存(Staging)

- 未暂存(Unstaged)的内容

- 分支(Branches)

- Rebasing 和合并(Merging)

- Stash

- 杂项(Miscellaneous Objects)

- 跟踪文件(Tracking Files)

- 配置(Configuration)

- 我不知道我做错了些什么

- 其它资源(Other Resources)

编辑提交(editting commits)

我刚才提交了什么?

如果你用 git commit -a 提交了一次变化(changes),而你又不确定到底这次提交了哪些内容。 你就可以用下面的命令显示当前HEAD上的最近一次的提交(commit):

(master)$ git show

或者

$ git log -n1 -p

我的提交信息(commit message)写错了

如果你的提交信息(commit message)写错了且这次提交(commit)还没有推(push), 你可以通过下面的方法来修改提交信息(commit message):

$ git commit --amend --only

这会打开你的默认编辑器, 在这里你可以编辑信息. 另一方面, 你也可以用一条命令一次完成:

$ git commit --amend --only -m 'xxxxxxx'

如果你已经推(push)了这次提交(commit), 你可以修改这次提交(commit)然后强推(force push), 但是不推荐这么做。

我提交(commit)里的用户名和邮箱不对

如果这只是单个提交(commit),修改它:

$ git commit --amend --author "New Authorname <authoremail@mydomain.com>"

如果你需要修改所有历史, 参考 ‘git filter-branch’的指南页.

我想从一个提交(commit)里移除一个文件

通过下面的方法,从一个提交(commit)里移除一个文件:

$ git checkout HEAD^ myfile

$ git add -A

$ git commit --amend

这将非常有用,当你有一个开放的补丁(open patch),你往上面提交了一个不必要的文件,你需要强推(force push)去更新这个远程补丁。

我想删除我的的最后一次提交(commit)

如果你需要删除推了的提交(pushed commits),你可以使用下面的方法。可是,这会不可逆的改变你的历史,也会搞乱那些已经从该仓库拉取(pulled)了的人的历史。简而言之,如果你不是很确定,千万不要这么做。

$ git reset HEAD^ --hard

$ git push -f [remote] [branch]

如果你还没有推到远程, 把Git重置(reset)到你最后一次提交前的状态就可以了(同时保存暂存的变化):

(my-branch*)$ git reset --soft HEAD@{1}

这只能在没有推送之前有用. 如果你已经推了, 唯一安全能做的是 git revert SHAofBadCommit, 那会创建一个新的提交(commit)用于撤消前一个提交的所有变化(changes); 或者, 如果你推的这个分支是rebase-safe的 (例如: 其它开发者不会从这个分支拉), 只需要使用 git push -f; 更多, 请参考 the above section。

删除任意提交(commit)

同样的警告:不到万不得已的时候不要这么做.

$ git rebase --onto SHA1_OF_BAD_COMMIT^ SHA1_OF_BAD_COMMIT

$ git push -f [remote] [branch]

或者做一个 交互式rebase 删除那些你想要删除的提交(commit)里所对应的行。

我尝试推一个修正后的提交(amended commit)到远程,但是报错:

To https://github.com/yourusername/repo.git

! [rejected] mybranch -> mybranch (non-fast-forward)

error: failed to push some refs to 'https://github.com/tanay1337/webmaker.org.git'

hint: Updates were rejected because the tip of your current branch is behind

hint: its remote counterpart. Integrate the remote changes (e.g.

hint: 'git pull ...') before pushing again.

hint: See the 'Note about fast-forwards' in 'git push --help' for details.

注意, rebasing(见下面)和修正(amending)会用一个新的提交(commit)代替旧的, 所以如果之前你已经往远程仓库上推过一次修正前的提交(commit),那你现在就必须强推(force push) (-f)。 注意 – 总是 确保你指明一个分支!

(my-branch)$ git push origin mybranch -f

一般来说, 要避免强推. 最好是创建和推(push)一个新的提交(commit),而不是强推一个修正后的提交。后者会使那些与该分支或该分支的子分支工作的开发者,在源历史中产生冲突。

我意外的做了一次硬重置(hard reset),我想找回我的内容

如果你意外的做了 git reset --hard, 你通常能找回你的提交(commit), 因为Git对每件事都会有日志,且都会保存几天。

(master)$ git reflog

你将会看到一个你过去提交(commit)的列表, 和一个重置的提交。 选择你想要回到的提交(commit)的SHA,再重置一次:

(master)$ git reset --hard SHA1234

这样就完成了。

暂存(Staging)

我需要把暂存的内容添加到上一次的提交(commit)

(my-branch*)$ git commit --amend

我想要暂存一个新文件的一部分,而不是这个文件的全部

一般来说, 如果你想暂存一个文件的一部分, 你可这样做:

$ git add --patch filename.x

-p 简写。这会打开交互模式, 你将能够用 s 选项来分隔提交(commit); 然而, 如果这个文件是新的, 会没有这个选择, 添加一个新文件时, 这样做:

$ git add -N filename.x

然后, 你需要用 e 选项来手动选择需要添加的行,执行 git diff --cached 将会显示哪些行暂存了哪些行只是保存在本地了。

我想把在一个文件里的变化(changes)加到两个提交(commit)里

git add 会把整个文件加入到一个提交. git add -p 允许交互式的选择你想要提交的部分.

我想把暂存的内容变成未暂存,把未暂存的内容暂存起来

多数情况下,你应该将所有的内容变为未暂存,然后再选择你想要的内容进行commit。 但假定你就是想要这么做,这里你可以创建一个临时的commit来保存你已暂存的内容,然后暂存你的未暂存的内容并进行stash。然后reset最后一个commit将原本暂存的内容变为未暂存,最后stash pop回来。

$ git commit -m "WIP"

$ git add .

$ git stash

$ git reset HEAD^

$ git stash pop --index 0

注意1: 这里使用pop仅仅是因为想尽可能保持幂等。

注意2: 假如你不加上--index你会把暂存的文件标记为为存储.这个链接 解释得比较清楚。(不过是英文的,其大意是说,这是一个较为底层的问题,stash时会做2个commit,其中一个会记录index状态,staged的文件等东西,另一个记录worktree和其他的一些东西,如果你不在apply时加index,git会把两个一起销毁,所以staged里就空了)。

未暂存(Unstaged)的内容

我想把未暂存的内容移动到一个新分支

$ git checkout -b my-branch

我想把未暂存的内容移动到另一个已存在的分支

$ git stash

$ git checkout my-branch

$ git stash pop

我想丢弃本地未提交的变化(uncommitted changes)

如果你只是想重置源(origin)和你本地(local)之间的一些提交(commit),你可以:

# one commit

(my-branch)$ git reset --hard HEAD^

# two commits

(my-branch)$ git reset --hard HEAD^^

# four commits

(my-branch)$ git reset --hard HEAD~4

# or

(master)$ git checkout -f

重置某个特殊的文件, 你可以用文件名做为参数:

$ git reset filename

我想丢弃某些未暂存的内容

如果你想丢弃工作拷贝中的一部分内容,而不是全部。

签出(checkout)不需要的内容,保留需要的。

$ git checkout -p

# Answer y to all of the snippets you want to drop

另外一个方法是使用 stash, Stash所有要保留下的内容, 重置工作拷贝, 重新应用保留的部分。

$ git stash -p

# Select all of the snippets you want to save

$ git reset --hard

$ git stash pop

或者, stash 你不需要的部分, 然后stash drop。

$ git stash -p

# Select all of the snippets you don't want to save

$ git stash drop

分支(Branches)

我从错误的分支拉取了内容,或把内容拉取到了错误的分支

这是另外一种使用 git reflog 情况,找到在这次错误拉(pull) 之前HEAD的指向。

(master)$ git reflog

ab7555f HEAD@{0}: pull origin wrong-branch: Fast-forward

c5bc55a HEAD@{1}: checkout: checkout message goes here

重置分支到你所需的提交(desired commit):

$ git reset --hard c5bc55a

完成。

我想扔掉本地的提交(commit),以便我的分支与远程的保持一致

先确认你没有推(push)你的内容到远程。

git status 会显示你领先(ahead)源(origin)多少个提交:

(my-branch)$ git status

# On branch my-branch

# Your branch is ahead of 'origin/my-branch' by 2 commits.

# (use "git push" to publish your local commits)

#

一种方法是:

(master)$ git reset --hard origin/my-branch

我需要提交到一个新分支,但错误的提交到了master

在master下创建一个新分支,不切换到新分支,仍在master下:

(master)$ git branch my-branch

把master分支重置到前一个提交:

(master)$ git reset --hard HEAD^

HEAD^ 是 HEAD^1 的简写,你可以通过指定要设置的HEAD来进一步重置。

或者, 如果你不想使用 HEAD^, 找到你想重置到的提交(commit)的hash(git log 能够完成), 然后重置到这个hash。 使用git push 同步内容到远程。

例如, master分支想重置到的提交的hash为a13b85e:

(master)$ git reset --hard a13b85e

HEAD is now at a13b85e

签出(checkout)刚才新建的分支继续工作:

(master)$ git checkout my-branch

我想保留来自另外一个ref-ish的整个文件

假设你正在做一个原型方案(原文为working spike (see note)), 有成百的内容,每个都工作得很好。现在, 你提交到了一个分支,保存工作内容:

(solution)$ git add -A && git commit -m "Adding all changes from this spike into one big commit."

当你想要把它放到一个分支里 (可能是feature, 或者 develop), 你关心是保持整个文件的完整,你想要一个大的提交分隔成比较小。

假设你有:

- 分支

solution, 拥有原型方案, 领先develop分支。 - 分支

develop, 在这里你应用原型方案的一些内容。

我去可以通过把内容拿到你的分支里,来解决这个问题:

(develop)$ git checkout solution -- file1.txt

这会把这个文件内容从分支 solution 拿到分支 develop 里来:

# On branch develop

# Your branch is up-to-date with 'origin/develop'.

# Changes to be committed:

# (use "git reset HEAD <file>..." to unstage)

#

# modified: file1.txt

然后, 正常提交。

Note: Spike solutions are made to analyze or solve the problem. These solutions are used for estimation and discarded once everyone gets clear visualization of the problem. ~ Wikipedia.

我把几个提交(commit)提交到了同一个分支,而这些提交应该分布在不同的分支里

假设你有一个master分支, 执行git log, 你看到你做过两次提交:

(master)$ git log

commit e3851e817c451cc36f2e6f3049db528415e3c114

Author: Alex Lee <alexlee@example.com>

Date: Tue Jul 22 15:39:27 2014 -0400

Bug #21 - Added CSRF protection

commit 5ea51731d150f7ddc4a365437931cd8be3bf3131

Author: Alex Lee <alexlee@example.com>

Date: Tue Jul 22 15:39:12 2014 -0400

Bug #14 - Fixed spacing on title

commit a13b85e984171c6e2a1729bb061994525f626d14

Author: Aki Rose <akirose@example.com>

Date: Tue Jul 21 01:12:48 2014 -0400

First commit

让我们用提交hash(commit hash)标记bug (e3851e8 for #21, 5ea5173 for #14).

首先, 我们把master分支重置到正确的提交(a13b85e):

(master)$ git reset --hard a13b85e

HEAD is now at a13b85e

现在, 我们对 bug #21 创建一个新的分支:

(master)$ git checkout -b 21

(21)$

接着, 我们用 cherry-pick 把对bug #21的提交放入当前分支。 这意味着我们将应用(apply)这个提交(commit),仅仅这一个提交(commit),直接在HEAD上面。

(21)$ git cherry-pick e3851e8

这时候, 这里可能会产生冲突, 参见交互式 rebasing 章 冲突节 解决冲突.

再者, 我们为bug #14 创建一个新的分支, 也基于master分支

(21)$ git checkout master

(master)$ git checkout -b 14

(14)$

最后, 为 bug #14 执行 cherry-pick:

(14)$ git cherry-pick 5ea5173

我想删除上游(upstream)分支被删除了的本地分支

一旦你在github 上面合并(merge)了一个pull request, 你就可以删除你fork里被合并的分支。 如果你不准备继续在这个分支里工作, 删除这个分支的本地拷贝会更干净,使你不会陷入工作分支和一堆陈旧分支的混乱之中。

$ git fetch -p

我不小心删除了我的分支

如果你定期推送到远程, 多数情况下应该是安全的,但有些时候还是可能删除了还没有推到远程的分支。 让我们先创建一个分支和一个新的文件:

(master)$ git checkout -b my-branch

(my-branch)$ git branch

(my-branch)$ touch foo.txt

(my-branch)$ ls

README.md foo.txt

添加文件并做一次提交

(my-branch)$ git add .

(my-branch)$ git commit -m 'foo.txt added'

(my-branch)$ foo.txt added

1 files changed, 1 insertions(+)

create mode 100644 foo.txt

(my-branch)$ git log

commit 4e3cd85a670ced7cc17a2b5d8d3d809ac88d5012

Author: siemiatj <siemiatj@example.com>

Date: Wed Jul 30 00:34:10 2014 +0200

foo.txt added

commit 69204cdf0acbab201619d95ad8295928e7f411d5

Author: Kate Hudson <katehudson@example.com>

Date: Tue Jul 29 13:14:46 2014 -0400

Fixes #6: Force pushing after amending commits

现在我们切回到主(master)分支,‘不小心的’删除my-branch分支

(my-branch)$ git checkout master

Switched to branch 'master'

Your branch is up-to-date with 'origin/master'.

(master)$ git branch -D my-branch

Deleted branch my-branch (was 4e3cd85).

(master)$ echo oh noes, deleted my branch!

oh noes, deleted my branch!

在这时候你应该想起了reflog, 一个升级版的日志,它存储了仓库(repo)里面所有动作的历史。

(master)$ git reflog

69204cd HEAD@{0}: checkout: moving from my-branch to master

4e3cd85 HEAD@{1}: commit: foo.txt added

69204cd HEAD@{2}: checkout: moving from master to my-branch

正如你所见,我们有一个来自删除分支的提交hash(commit hash),接下来看看是否能恢复删除了的分支。

(master)$ git checkout -b my-branch-help

Switched to a new branch 'my-branch-help'

(my-branch-help)$ git reset --hard 4e3cd85

HEAD is now at 4e3cd85 foo.txt added

(my-branch-help)$ ls

README.md foo.txt

看! 我们把删除的文件找回来了。 Git的 reflog 在rebasing出错的时候也是同样有用的。

我想删除一个分支

删除一个远程分支:

(master)$ git push origin --delete my-branch

你也可以:

(master)$ git push origin :my-branch

删除一个本地分支:

(master)$ git branch -D my-branch

我想从别人正在工作的远程分支签出(checkout)一个分支

首先, 从远程拉取(fetch) 所有分支:

(master)$ git fetch --all

假设你想要从远程的daves分支签出到本地的daves

(master)$ git checkout --track origin/daves

Branch daves set up to track remote branch daves from origin.

Switched to a new branch 'daves'

(--track 是 git checkout -b [branch] [remotename]/[branch] 的简写)

这样就得到了一个daves分支的本地拷贝, 任何推过(pushed)的更新,远程都能看到.

Rebasing 和合并(Merging)

我想撤销rebase/merge

你可以合并(merge)或rebase了一个错误的分支, 或者完成不了一个进行中的rebase/merge。 Git 在进行危险操作的时候会把原始的HEAD保存在一个叫ORIG_HEAD的变量里, 所以要把分支恢复到rebase/merge前的状态是很容易的。

(my-branch)$ git reset --hard ORIG_HEAD

我已经rebase过, 但是我不想强推(force push)

不幸的是,如果你想把这些变化(changes)反应到远程分支上,你就必须得强推(force push)。 是因你快进(Fast forward)了提交,改变了Git历史, 远程分支不会接受变化(changes),除非强推(force push)。这就是许多人使用 merge 工作流, 而不是 rebasing 工作流的主要原因之一, 开发者的强推(force push)会使大的团队陷入麻烦。使用时需要注意,一种安全使用 rebase 的方法是,不要把你的变化(changes)反映到远程分支上, 而是按下面的做:

(master)$ git checkout my-branch

(my-branch)$ git rebase -i master

(my-branch)$ git checkout master

(master)$ git merge --ff-only my-branch

更多, 参见 this SO thread.

我需要组合(combine)几个提交(commit)

假设你的工作分支将会做对于 master 的pull-request。 一般情况下你不关心提交(commit)的时间戳,只想组合 所有 提交(commit) 到一个单独的里面, 然后重置(reset)重提交(recommit)。 确保主(master)分支是最新的和你的变化都已经提交了, 然后:

(my-branch)$ git reset --soft master

(my-branch)$ git commit -am "New awesome feature"

如果你想要更多的控制, 想要保留时间戳, 你需要做交互式rebase (interactive rebase):

(my-branch)$ git rebase -i master

如果没有相对的其它分支, 你将不得不相对自己的HEAD 进行 rebase。 例如:你想组合最近的两次提交(commit), 你将相对于HEAD~2 进行rebase, 组合最近3次提交(commit), 相对于HEAD~3, 等等。

(master)$ git rebase -i HEAD~2

在你执行了交互式 rebase的命令(interactive rebase command)后, 你将在你的编辑器里看到类似下面的内容:

pick a9c8a1d Some refactoring

pick 01b2fd8 New awesome feature

pick b729ad5 fixup

pick e3851e8 another fix

# Rebase 8074d12..b729ad5 onto 8074d12

#

# Commands:

# p, pick = use commit

# r, reword = use commit, but edit the commit message

# e, edit = use commit, but stop for amending

# s, squash = use commit, but meld into previous commit

# f, fixup = like "squash", but discard this commit's log message

# x, exec = run command (the rest of the line) using shell

#

# These lines can be re-ordered; they are executed from top to bottom.

#

# If you remove a line here THAT COMMIT WILL BE LOST.

#

# However, if you remove everything, the rebase will be aborted.

#

# Note that empty commits are commented out

所有以 # 开头的行都是注释, 不会影响 rebase.

然后,你可以用任何上面命令列表的命令替换 pick, 你也可以通过删除对应的行来删除一个提交(commit)。

例如, 如果你想 单独保留最旧(first)的提交(commit),组合所有剩下的到第二个里面, 你就应该编辑第二个提交(commit)后面的每个提交(commit) 前的单词为 f:

pick a9c8a1d Some refactoring

pick 01b2fd8 New awesome feature

f b729ad5 fixup

f e3851e8 another fix

如果你想组合这些提交(commit) 并重命名这个提交(commit), 你应该在第二个提交(commit)旁边添加一个r,或者更简单的用s 替代 f:

pick a9c8a1d Some refactoring

pick 01b2fd8 New awesome feature

s b729ad5 fixup

s e3851e8 another fix

你可以在接下来弹出的文本提示框里重命名提交(commit)。

Newer, awesomer features

# Please enter the commit message for your changes. Lines starting

# with '#' will be ignored, and an empty message aborts the commit.

# rebase in progress; onto 8074d12

# You are currently editing a commit while rebasing branch 'master' on '8074d12'.

#

# Changes to be committed:

# modified: README.md

#

如果成功了, 你应该看到类似下面的内容:

(master)$ Successfully rebased and updated refs/heads/master.

安全合并(merging)策略

--no-commit 执行合并(merge)但不自动提交, 给用户在做提交前检查和修改的机会。 no-ff 会为特性分支(feature branch)的存在过留下证据, 保持项目历史一致。

(master)$ git merge --no-ff --no-commit my-branch

我需要将一个分支合并成一个提交(commit)

(master)$ git merge --squash my-branch

我只想组合(combine)未推的提交(unpushed commit)

有时候,在将数据推向上游之前,你有几个正在进行的工作提交(commit)。这时候不希望把已经推(push)过的组合进来,因为其他人可能已经有提交(commit)引用它们了。

(master)$ git rebase -i @{u}

这会产生一次交互式的rebase(interactive rebase), 只会列出没有推(push)的提交(commit), 在这个列表时进行reorder/fix/squash 都是安全的。

检查是否分支上的所有提交(commit)都合并(merge)过了

检查一个分支上的所有提交(commit)是否都已经合并(merge)到了其它分支, 你应该在这些分支的head(或任何 commits)之间做一次diff:

(master)$ git log --graph --left-right --cherry-pick --oneline HEAD...feature/120-on-scroll

这会告诉你在一个分支里有而另一个分支没有的所有提交(commit), 和分支之间不共享的提交(commit)的列表。 另一个做法可以是:

(master)$ git log master ^feature/120-on-scroll --no-merges

交互式rebase(interactive rebase)可能出现的问题

这个rebase 编辑屏幕出现’noop’

如果你看到的是这样:

noop

这意味着你rebase的分支和当前分支在同一个提交(commit)上, 或者 领先(ahead) 当前分支。 你可以尝试:

- 检查确保主(master)分支没有问题

- rebase

HEAD~2或者更早

有冲突的情况

如果你不能成功的完成rebase, 你可能必须要解决冲突。

首先执行 git status 找出哪些文件有冲突:

(my-branch)$ git status

On branch my-branch

Changes not staged for commit:

(use "git add <file>..." to update what will be committed)

(use "git checkout -- <file>..." to discard changes in working directory)

modified: README.md

在这个例子里面, README.md 有冲突。 打开这个文件找到类似下面的内容:

<<<<<<< HEAD

some code

=========

some code

>>>>>>> new-commit

你需要解决新提交的代码(示例里, 从中间==线到new-commit的地方)与HEAD 之间不一样的地方.

有时候这些合并非常复杂,你应该使用可视化的差异编辑器(visual diff editor):

(master*)$ git mergetool -t opendiff

在你解决完所有冲突和测试过后, git add 变化了的(changed)文件, 然后用git rebase --continue 继续rebase。

(my-branch)$ git add README.md

(my-branch)$ git rebase --continue

如果在解决完所有的冲突过后,得到了与提交前一样的结果, 可以执行git rebase --skip。

任何时候你想结束整个rebase 过程,回来rebase前的分支状态, 你可以做:

(my-branch)$ git rebase --abort

Stash

暂存所有改动

暂存你工作目录下的所有改动

$ git stash

你可以使用-u来排除一些文件

$ git stash -u

暂存指定文件

假设你只想暂存某一个文件

$ git stash push working-directory-path/filename.ext

假设你想暂存多个文件

$ git stash push working-directory-path/filename1.ext working-directory-path/filename2.ext

暂存时记录消息

这样你可以在list时看到它

$ git stash save <message>

或

$ git stash push -m <message>

使用某个指定暂存

首先你可以查看你的stash记录

$ git stash list

然后你可以apply某个stash

$ git stash apply "stash@{n}"

此处, ‘n’是stash在栈中的位置,最上层的stash会是0

除此之外,也可以使用时间标记(假如你能记得的话)。

$ git stash apply "stash@{2.hours.ago}"

暂存时保留未暂存的内容

你需要手动create一个stash commit, 然后使用git stash store。

$ git stash create

$ git stash store -m "commit-message" CREATED_SHA1

杂项(Miscellaneous Objects)

克隆所有子模块

$ git clone --recursive git://github.com/foo/bar.git

如果已经克隆了:

$ git submodule update --init --recursive

删除标签(tag)

$ git tag -d <tag_name>

$ git push <remote> :refs/tags/<tag_name>

恢复已删除标签(tag)

如果你想恢复一个已删除标签(tag), 可以按照下面的步骤: 首先, 需要找到无法访问的标签(unreachable tag):

$ git fsck --unreachable | grep tag

记下这个标签(tag)的hash,然后用Git的 update-ref:

$ git update-ref refs/tags/<tag_name> <hash>

这时你的标签(tag)应该已经恢复了。

已删除补丁(patch)

如果某人在 GitHub 上给你发了一个pull request, 但是然后他删除了他自己的原始 fork, 你将没法克隆他们的提交(commit)或使用 git am。在这种情况下, 最好手动的查看他们的提交(commit),并把它们拷贝到一个本地新分支,然后做提交。

做完提交后, 再修改作者,参见变更作者。 然后, 应用变化, 再发起一个新的pull request。

跟踪文件(Tracking Files)

我只想改变一个文件名字的大小写,而不修改内容

(master)$ git mv --force myfile MyFile

我想从Git删除一个文件,但保留该文件

(master)$ git rm --cached log.txt

配置(Configuration)

我想给一些Git命令添加别名(alias)

在 OS X 和 Linux 下, 你的 Git的配置文件储存在 ~/.gitconfig。我在[alias] 部分添加了一些快捷别名(和一些我容易拼写错误的),如下:

[alias]

a = add

amend = commit --amend

c = commit

ca = commit --amend

ci = commit -a

co = checkout

d = diff

dc = diff --changed

ds = diff --staged

f = fetch

loll = log --graph --decorate --pretty=oneline --abbrev-commit

m = merge

one = log --pretty=oneline

outstanding = rebase -i @{u}

s = status

unpushed = log @{u}

wc = whatchanged

wip = rebase -i @{u}

zap = fetch -p

我想缓存一个仓库(repository)的用户名和密码

你可能有一个仓库需要授权,这时你可以缓存用户名和密码,而不用每次推/拉(push/pull)的时候都输入,Credential helper能帮你。

$ git config --global credential.helper cache

# Set git to use the credential memory cache

$ git config --global credential.helper 'cache --timeout=3600'

# Set the cache to timeout after 1 hour (setting is in seconds)

我不知道我做错了些什么

你把事情搞砸了:你 重置(reset) 了一些东西, 或者你合并了错误的分支, 亦或你强推了后找不到你自己的提交(commit)了。有些时候, 你一直都做得很好, 但你想回到以前的某个状态。

这就是 git reflog 的目的, reflog 记录对分支顶端(the tip of a branch)的任何改变, 即使那个顶端没有被任何分支或标签引用。基本上, 每次HEAD的改变, 一条新的记录就会增加到reflog。遗憾的是,这只对本地分支起作用,且它只跟踪动作 (例如,不会跟踪一个没有被记录的文件的任何改变)。

(master)$ git reflog

0a2e358 HEAD@{0}: reset: moving to HEAD~2

0254ea7 HEAD@{1}: checkout: moving from 2.2 to master

c10f740 HEAD@{2}: checkout: moving from master to 2.2

上面的reflog展示了从master分支签出(checkout)到2.2 分支,然后再签回。 那里,还有一个硬重置(hard reset)到一个较旧的提交。最新的动作出现在最上面以 HEAD@{0}标识.

如果事实证明你不小心回移(move back)了提交(commit), reflog 会包含你不小心回移前master上指向的提交(0254ea7)。

$ git reset --hard 0254ea7

然后使用git reset就可以把master改回到之前的commit,这提供了一个在历史被意外更改情况下的安全网。

(摘自).

其它资源(Other Resources)

书(Books)

- Pro Git - Scott Chacon’s excellent git book

- Git Internals - Scott Chacon’s other excellent git book

教程(Tutorials)

- Learn Git branching 一个基于网页的交互式 branching/merging/rebasing 教程

- Getting solid at Git rebase vs. merge

- git-workflow - Aaron Meurer的怎么使用Git为开源仓库贡献

- GitHub as a workflow - 使用GitHub做为工作流的趣事, 尤其是空PRs

脚本和工具(Scripts and Tools)

- firstaidgit.io 一个可搜索的最常被问到的Git的问题

- git-extra-commands - 一堆有用的额外的Git脚本

- git-extras - GIT 工具集 – repo summary, repl, changelog population, author commit percentages and more

- git-fire - git-fire 是一个 Git 插件,用于帮助在紧急情况下添加所有当前文件, 做提交(committing), 和推(push)到一个新分支(阻止合并冲突)。

- git-tips - Git小提示

- git-town - 通用,高级Git工作流支持! http://www.git-town.com

GUI客户端(GUI Clients)

- GitKraken - 豪华的Git客户端 Windows, Mac & Linux

- git-cola - 另外一个Git客户端 Windows & OS X

- GitUp - 一个新的Git客户端,在处理Git的复杂性上有自己的特点

- gitx-dev - 图形化的Git客户端 OS X

- Source Tree - 免费的图形化Git客户端 Windows & OS X

- Tower - 图形化Git客户端 OS X(付费)����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������_posts/2018-03-07-Git-Gitignore.md������������������������������������������������������������������0000664�0001750�0001750�00000002566�14127026255�016330� 0����������������������������������������������������������������������������������������������������ustar �wangwen�������������������������wangwen����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������—

layout: post

title: 使用 .gitignore 忽略 Git 仓库中的文件

subtitle: .gitignore 文件在Git中的使用

date: 2018-03-07

author: AnAn

header-img: /img/post-bg-article.jpg

catalog: true

tags:

-

Git

-

使用

.gitignore文件忽略指定文件

.gitignore

在Git中,很多时候你只想将代码提交到仓库,而不是将当前文件目录下的文件全部提交到Git仓库中,例如在MacOS系统下面的.DS_Store文件,或者是Xocde的操作记录,又或者是pod库的中一大串的源代码。这种情况下使用.gitignore就能够在Git提交时自动忽略掉这些文件。

忽略的格式

#:此为注释 – 将被 Git 忽略*.a:忽略所有.a结尾的文件!lib.a: 不忽略lib.a文件/TODO:仅仅忽略项目根目录下的TODO文件,不包括subdir/TODObuild/: 忽略build/目录下的所有文件doc/*.txt: 会忽略doc/notes.txt但不包括doc/server/arch.txt

创建方法

从 github 上获取

github上整理了一些常用需要的项目中需要忽略的文件配置,根据需要进行获取

https://github.com/github/gitignore.git

IDEA中使用gitignore插件为项目创建.gitignore

- .ignore support plugin for IntelliJ IDEA������������������������������������������������������������������������������������������������������������������������������������������_posts/2018-04-08-Java-Collection.md����������������������������������������������������������������0000664�0001750�0001750�00000005420�14127043406�016621� 0����������������������������������������������������������������������������������������������������ustar �wangwen�������������������������wangwen����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������—

layout: post

title: Java集合体系

subtitle: Java集合体系分类与关系

date: 2018-04-08

author: AnAn

header-img: /img/post-bg-article.jpg

catalog: true

tags:

-

Java

-

集合

单列集合-collection

有序集合List

ArrayList:

- ArrayList是一个动态数组,也是我们最常用的集合。

- 它允许任何符合规则的元素插入甚至包括null。

- 每一个ArrayList都有一个初始容量(10),该容量代表了数组的大小。

- 随着容器中的元素不断增加,容器的大小也会随着增加。在每次向容器中增加元素的同时都会进行容量检查,当快溢出时,就会进行扩容操作。

- 所以如果我们明确所插入元素的多少,最好指定一个初始容量值,避免过多的进行扩容操作而浪费时间、效率。

LinkedList:

- 是一个双链表,在添加和删除元素时具比ArrayList更好的性能;

- 它除了有ArrayList的基本操作方法外还额外提供了get,remove,insert方法在LinkedList的首部或尾部。

- 由于实现的方式不同,LinkedList不能随机访问,它所有的操作都是要按照双重链表的需要执行。

- 在列表中索引的操作将从开头或结尾遍历列表(从靠近指定索引的一端)。

- 这样做的好处就是可以通过较低的代价在List中进行插入和删除操作。

Vector:

- 相当于是一个线程安全的ArrayList,效率比较底下,如果对安全性有要求的话可以考虑使用Vector

无序集合set

HashSet:

- 无序不重复,线程不安全,放入的元素可以为null;

- HashSet集合判断两个元素相等的标准是两个对象通过equals方法比较相等,并且两个对象的hashCode()方法返回值相等

LinkedHashSet:

- 按放入顺序有序不重复

TreeSet:

- 按红黑树方式有序不重复;

- TreeSet 是二差树实现的,Treeset中的数据是自动排好序的,不允许放入null值。

多列集合-map

HashMap:

- 线程不安全;

- 可以接受为null的键值(key)和值(value);

- 不能保证随着时间的推移Map中的元素次序是不变的;

- HashMap可以通过下面的语句进行同步: Map m = Collections.synchronizeMap(hashMap);

HashTable:

- 线程安全;

- 不接受null值;

- Java5提供了ConcurrentHashMap,它是HashTable的替代,比HashTable的扩展性更好;

- 如果你不需要线程安全,那么使用HashMap,如果需要线程安全,那么使用ConcurrentHashMap。HashTable已经被淘汰了,不要在新的代码中再使用它。

- 为什么HashTable已经淘汰了,还要优化它?因为有老的代码还在使用它,所以优化了它之后,这些老的代码也能获得性能提升。������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������_posts/2018-07-19-Spring-事务(Transaction).md�����������������������������������������������������0000664�0001750�0001750�00000007143�13770775644�021642� 0����������������������������������������������������������������������������������������������������ustar �wangwen�������������������������wangwen����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������—

layout: post

title: Spring事务(Transaction)

subtitle: 七种事务传播行为及五种隔离级别

date: 2018-07-19

author: AnAn

header-img: /img/post-bg-article.jpg

catalog: true

tags:

- Spring

-

Transaction

1. 首先,说说什么事务(Transaction)

- 事务,就是一组操作数据库的动作集合。事务是现代数据库理论中的核心概念之一。

- 如果一组处理步骤或者全部发生或者一步也不执行,我们称该组处理步骤为一个事务。

- 当所有的步骤像一个操作一样被完整地执行,我们称该事务被提交。

- 由于其中的一部分或多步执行失败,导致没有步骤被提交,则事务必须回滚到最初的系统状态。

2. spring七个事务传播属性:

- PROPAGATION_REQUIRED

- 支持当前事务,如果当前没有事务,就新建一个事务。这是最常见的选择。

- PROPAGATION_SUPPORTS

- 支持当前事务,如果当前没有事务,就以非事务方式执行。

- PROPAGATION_MANDATORY

- 支持当前事务,如果当前没有事务,就抛出异常。

- PROPAGATION_REQUIRES_NEW

- 新建事务,如果当前存在事务,把当前事务挂起。

- PROPAGATION_NOT_SUPPORTED

- 以非事务方式执行操作,如果当前存在事务,就把当前事务挂起。

- PROPAGATION_NEVER

- 以非事务方式执行,如果当前存在事务,则抛出异常。

- PROPAGATION_NESTED

- 如果当前存在事务,则在嵌套事务内执行。如果当前没有事务,则进行与PROPAGATION_REQUIRED类似的操作。 - 备注:常用的两个事务传播属性是1和4,即PROPAGATION_REQUIRED,PROPAGATION_REQUIRES_NEW

3. 五个隔离级别:

- ISOLATION_DEFAULT

- 这是一个PlatfromTransactionManager默认的隔离级别,使用数据库默认的事务隔离级别.

- 另外四个与JDBC的隔离级别相对应;

- ISOLATION_READ_UNCOMMITTED

- 这是事务最低的隔离级别,它充许别外一个事务可以看到这个事务未提交的数据。

- 这种隔离级别会产生脏读,不可重复读和幻像读。

- ISOLATION_READ_COMMITTED

- 保证一个事务修改的数据提交后才能被另外一个事务读取。另外一个事务不能读取该事务未提交的数据。

- 这种事务隔离级别可以避免脏读出现,但是可能会出现不可重复读和幻像读。

- ISOLATION_REPEATABLE_READ

- 这种事务隔离级别可以防止脏读,不可重复读。但是可能出现幻像读。

- 它除了保证一个事务不能读取另一个事务未提交的数据外,还保证了避免下面的情况产生(不可重复读)。

- ISOLATION_SERIALIZABLE

- 这是花费最高代价但是最可靠的事务隔离级别。事务被处理为顺序执行。

- 除了防止脏读,不可重复读外,还避免了幻像读。

关键词:

- 幻读:事务1读取记录时事务2增加了记录并提交,事务1再次读取时可以看到事务2新增的记录;

- 不可重复读取:事务1读取记录时,事务2更新了记录并提交,事务1再次读取时可以看到事务2修改后的记录;

- 脏读:事务1更新了记录,但没有提交,事务2读取了更新后的行,然后事务T1回滚,现在T2读取无效。

脏读:

- 指一个事务读取了一个未提交事务的数据

不可重复读:

- 在一个事务内读取表中的某一行数据,多次读取结果不同.一个事务读取到了另一个事务提交后的数据.

虚读(幻读):

- 在一个事务内读取了别的事务插入的数据,导致前后读取不一致(insert)�����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������_posts/2018-07-21-Spring-核心模块解析.md������������������������������������������������������0000664�0001750�0001750�00000002426�13763566257�023575� 0����������������������������������������������������������������������������������������������������ustar �wangwen�������������������������wangwen����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������—

layout: post

title: Spring的核心模块解析

subtitle: 拆解spring框架的功能模块

date: 2018-07-21

author: AnAn

header-img: /img/post-bg-article.jpg

catalog: true

tags:

-

Spring

-

Spring图中的这些模块,都至少由一个以上的jar包组成。

1、Core Container - 核心容器

spring-core:Spring中的核心工具类包。

spring-beans:Spring中定义bean的组件。

spring-context:Spring的运行容器。

spring-context-support:Spring容器的扩展支持。

spring-expression:Spring的表达式语言支持。

2、AOP - 面向切面编程

spring-aop:基于代理的AOP支持。

spring-aspects:集成Aspects的AOP支持。

3、WEB(MVC)

spring-web:提供web的基础功能。

spring-webmvc:提供springmvc的功能。

spring-websocket:提供web socket支持。

spring-webmvc-portlet:提供Portlet环境的支持。

4、Data Access/Integration - 数据访问/集成

spring-jdbc:提供对jdbc连接的封装功能。

spring-tx:提供对事务的支持。

spring-orm:提供对象-关系映射支持。

spring-oxm:提供对象-XML映射支持。

spring-jms:提供消息队列的支持。

5、Test - 测试

spring-test:提供对测试功能的支持。������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������_posts/2018-07-23-Spring-SpringMVC9大组件概览.md�����������������������������������������������0000664�0001750�0001750�00000012267�13763566257�024362� 0����������������������������������������������������������������������������������������������������ustar �wangwen�������������������������wangwen����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������— layout: post title: SpringMVC9大组件概览 subtitle: 学习SpringMVC的架构 date: 2018-07-23 author: AnAn header-img: /img/post-bg-article.jpg catalog: true tags: - Spring - SpringMVC —

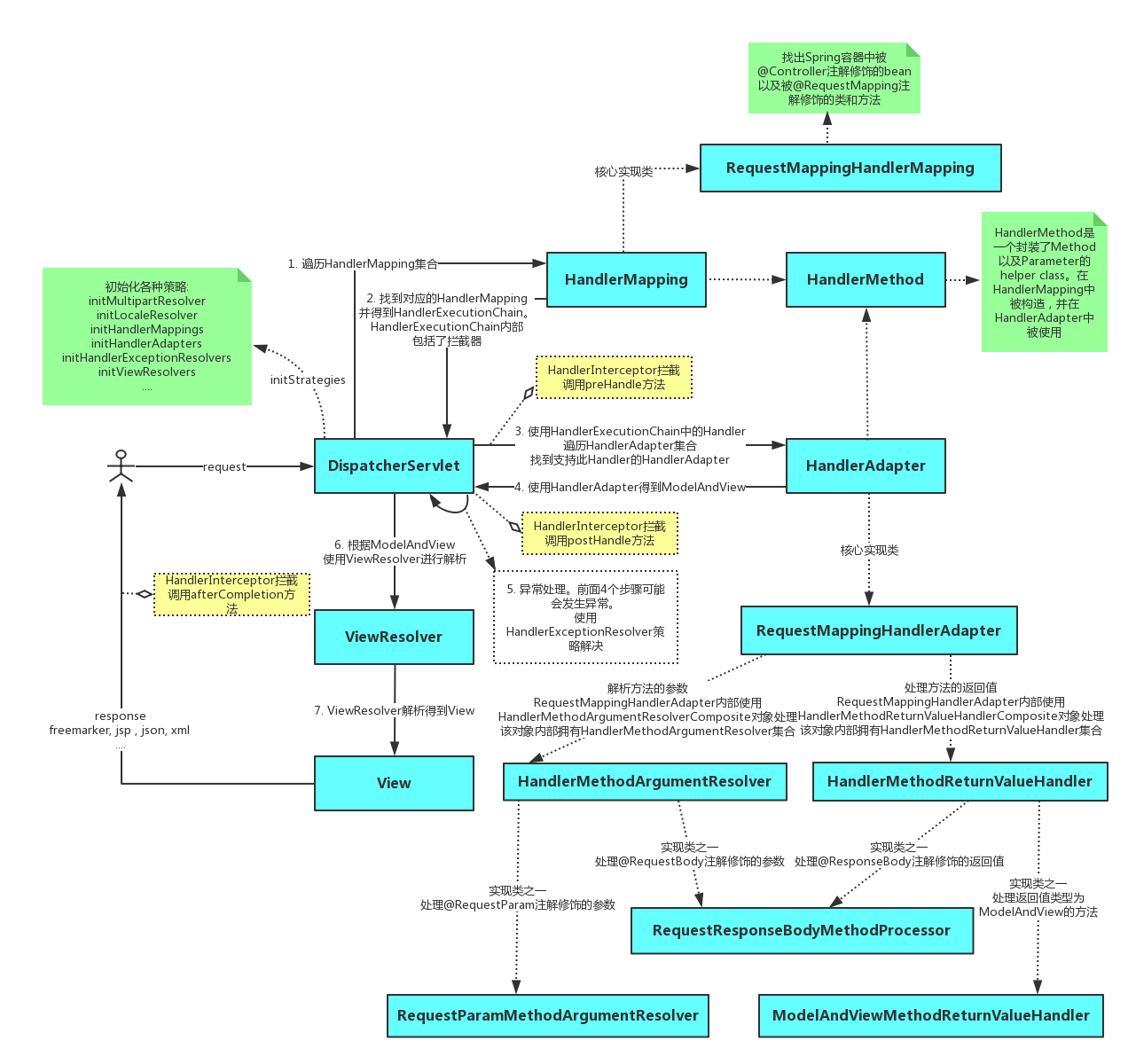

SpringMVC中的Servlet一共有三个层次,分别是HttpServletBean、FrameworkServlet和 DispatcherServlet。

HttpServletBean直接继承自java的HttpServlet,其作用是将Servlet中配置的参数设置到相应的属性;

FrameworkServlet初始化了WebApplicationContext,DispatcherServlet初始化了自身的9个组件。

在学习9个组件之前,我们需要先了解Handler的概念,也就是处理器。它直接应对着MVC中的C也就是Controller层,它的具体表现形式有很多,可以是类,也可以是方法。在Controller层中@RequestMapping标注的所有方法都可以看成是一个Handler,只要可以实际处理请求就可以是Handler。

Handler的概念清楚了,下面开始对9个组件一一介绍。

【1. HandlerMapping】处理器映射器

是用来查找Handler的。在SpringMVC中会有很多请求,每个请求都需要一个Handler处理,具体接收到一个请求之后使用哪个Handler进行处理呢?这就是HandlerMapping需要做的事。

【2. HandlerAdapter】处理器适配器

从名字上看,它就是一个适配器。因为SpringMVC中的Handler可以是任意的形式,只要能处理请求就ok,但是Servlet需要的处理方法的结构却是固定的,都是以request和response为参数的方法。如何让固定的Servlet处理方法调用灵活的Handler来进行处理呢?这就是HandlerAdapter要做的事情。

小结: Handler是用来干活的工具;HandlerMapping用于根据需要干的活找到相应的工具;HandlerAdapter是使用工具干活的人。

【3. HandlerExceptionResolver】

其它组件都是用来干活的。在干活的过程中难免会出现问题,出问题后怎么办呢?这就需要有一个专门的角色对异常情况进行处理,在SpringMVC中就是HandlerExceptionResolver。具体来说,此组件的作用是根据异常设置ModelAndView,之后再交给render方法进行渲染。

【4. ViewResolver】视图解析器

ViewResolver用来将String类型的视图名和Locale解析为View类型的视图。View是用来渲染页面的,也就是将程序返回的参数填入模板里,生成html(也可能是其它类型)文件。这里就有两个关键问题:使用哪个模板?用什么技术(规则)填入参数?这其实是ViewResolver主要要做的工作,ViewResolver需要找到渲染所用的模板和所用的技术(也就是视图的类型)进行渲染,具体的渲染过程则交由不同的视图自己完成。

【5. RequestToViewNameTranslator】

ViewName是根据ViewName查找View,但有的Handler处理完后并没有设置View也没有设置ViewName,这时就需要从request获取ViewName了,如何从request中获取ViewName就是RequestToViewNameTranslator要做的事情了。RequestToViewNameTranslator在Spring MVC容器里只可以配置一个,所以所有request到ViewName的转换规则都要在一个Translator里面全部实现。

【6. LocaleResolver】

解析视图需要两个参数:一是视图名,另一个是Locale。视图名是处理器返回的,Locale是从哪里来的?这就是LocaleResolver要做的事情。LocaleResolver用于从request解析出Locale,Locale就是zh-cn之类,表示一个区域,有了这个就可以对不同区域的用户显示不同的结果。SpringMVC主要有两个地方用到了Locale:一是ViewResolver视图解析的时候;二是用到国际化资源或者主题的时候。

【7. ThemeResolver】

用于解析主题。SpringMVC中一个主题对应一个properties文件,里面存放着跟当前主题相关的所有资源、如图片、css样式等。SpringMVC的主题也支持国际化,同一个主题不同区域也可以显示不同的风格。SpringMVC中跟主题相关的类有 ThemeResolver、ThemeSource和Theme。主题是通过一系列资源来具体体现的,要得到一个主题的资源,首先要得到资源的名称,这是ThemeResolver的工作。然后通过主题名称找到对应的主题(可以理解为一个配置)文件,这是ThemeSource的工作。最后从主题中获取资源就可以了。

【8. MultipartResolver】

用于处理上传请求。处理方法是将普通的request包装成MultipartHttpServletRequest,后者可以直接调用getFile方法获取File,如果上传多个文件,还可以调用getFileMap得到FileName->File结构的Map。此组件中一共有三个方法,作用分别是判断是不是上传请求,将request包装成MultipartHttpServletRequest、处理完后清理上传过程中产生的临时资源。

【9. FlashMapManager】

用来管理FlashMap的,FlashMap主要用在redirect中传递参数。

【总结】

至此,SpringMVC中的9大组件也就简单地概述了一遍。通过对此9大组件的宏观认识,对分析SpringMVC的设计、原理与实现都会有很大的帮助作用。 �����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������_posts/2018-07-25-Spring-SpringMVC的拦截器和过滤器.md���������������������������������������0000664�0001750�0001750�00000022222�14127043405�027305� 0����������������������������������������������������������������������������������������������������ustar �wangwen�������������������������wangwen����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������— layout: post title: SpringMVC的拦截器和过滤器 subtitle: SpringMVC的拦截器(Interceptor)和过滤器(Filter)的区别与联系 date: 2018-07-25 author: AnAn header-img: /img/post-bg-article.jpg catalog: true tags: - Spring - SpringMVC —

一 简介

(1)过滤器:

依赖于servlet容器。在实现上基于函数回调,可以对几乎所有请求进行过滤,但是缺点是一个过滤器实例只能在容器初始化时调用一次。使用过滤器的目的是用来做一些过滤操作,获取我们想要获取的数据,比如:在过滤器中修改字符编码;在过滤器中修改HttpServletRequest的一些参数,包括:过滤低俗文字、危险字符等

继承HttpServletRequestWrapper以实现在Filter中修改HttpServletRequest的参数

在SpringMVC中使用过滤器(Filter)过滤容易引发XSS的危险字符

(2)拦截器:

依赖于web框架,在SpringMVC中就是依赖于SpringMVC框架。在实现上基于Java的反射机制,属于面向切面编程(AOP) 的一种运用。由于拦截器是基于web框架的调用,因此可以使用Spring的依赖注入(DI) 进行一些业务操作,同时一个拦截器实例在一个controller生命周期之内可以多次调用。但是缺点是只能对controller请求进行拦截,对其他的一些比如直接访问静态资源的请求则没办法进行拦截处理

在SpringMVC中使用拦截器(interceptor)拦截CSRF攻击(修)

SpringMVC中使用Interceptor+cookie实现在一定天数之内自动登录

二 多个过滤器与拦截器的代码执行顺序

如果在一个项目中仅仅只有一个拦截器或者过滤器,那么我相信相对来说理解起来是比较容易的。但是我们是否思考过:如果一个项目中有多个拦截器或者过滤器,那么它们的执行顺序应该是什么样的?或者再复杂点,一个项目中既有多个拦截器,又有多个过滤器,这时它们的执行顺序又是什么样的呢?

下面我将用简单的代码来测试说明:

- 先定义两个过滤器:

- 过滤器1: ```java import java.io.IOException;

import javax.servlet.FilterChain; import javax.servlet.ServletException; import javax.servlet.http.HttpServletRequest; import javax.servlet.http.HttpServletResponse;

import org.springframework.web.filter.OncePerRequestFilter;

public class TestFilter1 extends OncePerRequestFilter { protected void doFilterInternal(HttpServletRequest request, HttpServletResponse response, FilterChain filterChain) throws ServletException, IOException { //在DispatcherServlet之前执行 system.out.println(“############TestFilter1 doFilterInternal executed############”); filterChain.doFilter(request, response); //在视图页面返回给客户端之前执行,但是执行顺序在Interceptor之后 System.out.println(“############TestFilter1 doFilter after############”); // try { // Thread.sleep(10000); // } catch (InterruptedException e) { // e.printStackTrace(); // } } }

2. 过滤器2: ```java import java.io.IOException; import javax.servlet.FilterChain; import javax.servlet.ServletException; import javax.servlet.http.HttpServletRequest; import javax.servlet.http.HttpServletResponse; import org.springframework.web.filter.OncePerRequestFilter; public class TestFilter2 extends OncePerRequestFilter { protected void doFilterInternal(HttpServletRequest request, HttpServletResponse response, FilterChain filterChain) throws ServletException, IOException { System.out.println("############TestFilter2 doFilterInternal executed############"); filterChain.doFilter(request, response); System.out.println("############TestFilter2 doFilter after############"); } }- 在web.xml中注册这两个过滤器:

<!-- 自定义过滤器:testFilter1 --> <filter> <filter-name>testFilter1</filter-name> <filter-class>cn.zifangsky.filter.TestFilter1</filter-class> </filter> <filter-mapping> <filter-name>testFilter1</filter-name> <url-pattern>/*</url-pattern> </filter-mapping> <!-- 自定义过滤器:testFilter2 --> <filter> <filter-name>testFilter2</filter-name> <filter-class>cn.zifangsky.filter.TestFilter2</filter-class> </filter> <filter-mapping> <filter-name>testFilter2</filter-name> <url-pattern>/*</url-pattern> </filter-mapping>

- 再定义两个拦截器:

- 拦截器1,基本拦截器: ```java import javax.servlet.http.HttpServletRequest; import javax.servlet.http.HttpServletResponse;

import org.springframework.web.servlet.HandlerInterceptor; import org.springframework.web.servlet.ModelAndView;

public class BaseInterceptor implements HandlerInterceptor{

/** 在DispatcherServlet之前执行 / public boolean preHandle(HttpServletRequest arg0, HttpServletResponse arg1, Object arg2) throws Exception { System.out.println(“****BaseInterceptor preHandle executed***”); return true; } /** 在controller执行之后的DispatcherServlet之后执行 / public void postHandle(HttpServletRequest arg0, HttpServletResponse arg1, Object arg2, ModelAndView arg3) throws Exception { System.out.println(“****BaseInterceptor postHandle executed***”); } /** 在页面渲染完成返回给客户端之前执行 / public void afterCompletion(HttpServletRequest arg0, HttpServletResponse arg1, Object arg2, Exception arg3) throws Exception { System.out.println(“****BaseInterceptor afterCompletion executed***”);// Thread.sleep(10000); } }

2. 指定controller请求的拦截器: ```java import javax.servlet.http.HttpServletRequest; import javax.servlet.http.HttpServletResponse; import org.springframework.web.servlet.HandlerInterceptor; import org.springframework.web.servlet.ModelAndView; public class TestInterceptor implements HandlerInterceptor { public boolean preHandle(HttpServletRequest arg0, HttpServletResponse arg1, Object arg2) throws Exception { System.out.println("************TestInterceptor preHandle executed**********"); return true; } public void postHandle(HttpServletRequest arg0, HttpServletResponse arg1, Object arg2, ModelAndView arg3) throws Exception { System.out.println("************TestInterceptor postHandle executed**********"); } public void afterCompletion(HttpServletRequest arg0, HttpServletResponse arg1, Object arg2, Exception arg3) throws Exception { System.out.println("************TestInterceptor afterCompletion executed**********"); } }- 在SpringMVC的配置文件中注册这两个拦截器:

<!-- 拦截器 --> <mvc:interceptors> <!-- 对所有请求都拦截,公共拦截器可以有多个 --> <bean name="baseInterceptor" class="cn.zifangsky.interceptor.BaseInterceptor" /> <!-- <bean name="testInterceptor" class="cn.zifangsky.interceptor.TestInterceptor" /> --> <mvc:interceptor> <!-- 对/test.html进行拦截 --> <mvc:mapping path="/test.html"/> <!-- 特定请求的拦截器只能有一个 --> <bean class="cn.zifangsky.interceptor.TestInterceptor" /> </mvc:interceptor> </mvc:interceptors>

- 定义一个测试使用的controller: ```java import org.springframework.stereotype.Controller; import org.springframework.web.bind.annotation.RequestMapping; import org.springframework.web.servlet.ModelAndView;

@Controller public class TestController {

@RequestMapping("/test.html")

public ModelAndView handleRequest(){

System.out.println("---------TestController executed--------");

return new ModelAndView("test");

} } ``` 4. 视图页面test.jsp: ```xml <%@ page language="java" contentType="text/html; charset=UTF-8" pageEncoding="UTF-8"%> <% String path = request.getContextPath(); String basePath = request.getScheme()+"://"+request.getServerName()+":"+request.getServerPort()+path+"/"; %>

5. 测试效果:

- 说明了过滤器的运行是依赖于servlet容器的,跟springmvc等框架并没有关系。并且,多个过滤器的执行顺序跟xml文件中定义的先后关系有关

- 对于过个拦截器它们之间的执行顺序跟在SpringMVC的配置文件中定义的先后顺序有关

������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������_posts/2018-07-27-Spring-注解与配置.md���������������������������������������������������������0000664�0001750�0001750�00000040152�13763566257�022570� 0����������������������������������������������������������������������������������������������������ustar �wangwen�������������������������wangwen����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������---

layout: post

title: Spring注解与配置

subtitle: 注解、配置、容器、bean

date: 2018-07-27

author: AnAn

header-img: /img/post-bg-article.jpg

catalog: true

tags:

- Spring

---

### 程序耦合的问题

```java

/**

* 程序的耦合

* 耦合:程序间的依赖关系

* 包括:

* 类之间的依赖

* 方法间的依赖

* 解耦:

* 降低程序间的依赖关系

* 实际开发中:

* 应该做到:编译期不依赖,运行时才依赖。

* 解耦的思路:

* 第一步:使用反射来创建对象,而避免使用new关键字。

* 第二步:通过读取配置文件来获取要创建的对象全限定类名

*

*/

spring的Ioc核心容器管理对象

/**

* 获取spring的Ioc核心容器,并根据id获取对象

*

* ApplicationContext的三个常用实现类:

* ClassPathXmlApplicationContext:它可以加载类路径下的配置文件,要求配置文件必须在类路径下。不在的话,加载不了。(更常用)

* FileSystemXmlApplicationContext:它可以加载磁盘任意路径下的配置文件(必须有访问权限)

*

* AnnotationConfigApplicationContext:它是用于读取注解创建容器的,是明天的内容。

*

* 核心容器的两个接口引发出的问题:

* ApplicationContext: 单例对象适用 采用此接口

* 它在构建核心容器时,创建对象采取的策略是采用立即加载的方式。也就是说,只要一读取完配置文件马上就创建配置文件中配置的对象。

*

* BeanFactory: 多例对象使用

* 它在构建核心容器时,创建对象采取的策略是采用延迟加载的方式。也就是说,什么时候根据id获取对象了,什么时候才真正的创建对象。

*/

关于bean标签的知识点

<!--把对象的创建交给spring来管理-->

<!--

spring对bean的管理细节:

1.创建bean的三种方式

2.bean对象的作用范围

3.bean对象的生命周期

-->

<!--创建Bean的三种方式 -->

<!-- 第一种方式:使用默认构造函数创建。

在spring的配置文件中使用bean标签,配以id和class属性之后,且没有其他属性和标签时。

采用的就是默认构造函数创建bean对象,此时如果类中没有默认构造函数,则对象无法创建。

-->

<bean id="accountService" class="cn.flyingd.service.impl.AccountServiceImpl"></bean>

<!-- 第二种方式: 使用普通工厂中的方法创建对象(使用某个类中的方法创建对象,并存入spring容器)-->

<bean id="instanceFactory" class="cn.flyingd.factory.InstanceFactory"></bean>

<bean id="accountService" factory-bean="instanceFactory" factory-method="getAccountService"></bean>

<!-- 第三种方式:使用工厂中的静态方法创建对象(使用某个类中的静态方法创建对象,并存入spring容器)-->

<bean id="accountService" class="cn.flyingd.factory.StaticFactory" factory-method="getAccountService"></bean>

<!-- bean的作用范围调整

bean标签的scope属性:

作用:用于指定bean的作用范围

取值: 常用的就是单例的和多例的

singleton:单例的(默认值)

prototype:多例的

request:作用于web应用的请求范围

session:作用于web应用的会话范围

global-session:作用于集群环境的会话范围(全局会话范围),当不是集群环境时,它就是session

-->

<bean id="accountService" class="cn.flyingd.service.impl.AccountServiceImpl" scope="prototype"></bean>

<!-- bean对象的生命周期

单例对象

出生:当容器创建时对象出生

活着:只要容器还在,对象一直活着

死亡:容器销毁,对象消亡

总结:单例对象的生命周期和容器相同

多例对象

出生:当我们使用对象时spring框架为我们创建

活着:对象只要是在使用过程中就一直活着。

死亡:当对象长时间不用,且没有别的对象引用时,由Java的垃圾回收器回收

-->

DI(依赖注入)

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://www.springframework.org/schema/beans

http://www.springframework.org/schema/beans/spring-beans.xsd">

<!-- spring中的依赖注入

依赖注入:

Dependency Injection

IOC的作用:

降低程序间的耦合(依赖关系)

依赖关系的管理:

以后都交给spring来维护

在当前类需要用到其他类的对象,由spring为我们提供,我们只需要在配置文件中说明

依赖关系的维护:

就称之为依赖注入。

依赖注入:

能注入的数据:有三类

基本类型和String

其他bean类型(在配置文件中或者注解配置过的bean)

复杂类型/集合类型

注入的方式:有三种

第一种:使用构造函数提供

第二种:使用set方法提供

第三种:使用注解提供(明天的内容)

-->

<!--构造函数注入:

使用的标签:constructor-arg

标签出现的位置:bean标签的内部

标签中的属性

type:用于指定要注入的数据的数据类型,该数据类型也是构造函数中某个或某些参数的类型

index:用于指定要注入的数据给构造函数中指定索引位置的参数赋值。索引的位置是从0开始

name:用于指定给构造函数中指定名称的参数赋值 常用的

=============以上三个用于指定给构造函数中哪个参数赋值===============================

value:用于提供基本类型和String类型的数据

ref:用于指定其他的bean类型数据。它指的就是在spring的Ioc核心容器中出现过的bean对象

优势:

在获取bean对象时,注入数据是必须的操作,否则对象无法创建成功。

弊端:

改变了bean对象的实例化方式,使我们在创建对象时,如果用不到这些数据,也必须提供。

-->

<bean id="accountService" class="cn.flyingd.service.impl.AccountServiceImpl">

<constructor-arg name="name" value="泰斯特"></constructor-arg>

<constructor-arg name="age" value="18"></constructor-arg>

<constructor-arg name="birthday" ref="now"></constructor-arg>

</bean>

<!-- 配置一个日期对象 -->

<bean id="now" class="java.util.Date"></bean>

<!-- set方法注入 更常用的方式

涉及的标签:property

出现的位置:bean标签的内部

标签的属性

name:用于指定注入时所调用的set方法名称

value:用于提供基本类型和String类型的数据

ref:用于指定其他的bean类型数据。它指的就是在spring的Ioc核心容器中出现过的bean对象

优势:

创建对象时没有明确的限制,可以直接使用默认构造函数

弊端:

如果有某个成员必须有值,则获取对象是有可能set方法没有执行。

-->

<bean id="accountService2" class="cn.flyingd.service.impl.AccountServiceImpl2">

<property name="name" value="TEST" ></property>

<property name="age" value="21"></property>

<property name="birthday" ref="now"></property>

</bean>

<!-- 复杂类型的注入/集合类型的注入

用于给List结构集合注入的标签:

list array set

用于个Map结构集合注入的标签:

map props

结构相同,标签可以互换

-->

<bean id="accountService3" class="cn.flyingd.service.impl.AccountServiceImpl3">

<property name="myStrs">

<set>

<value>AAA</value>

<value>BBB</value>

<value>CCC</value>

</set>

</property>

<property name="myList">

<array>

<value>AAA</value>

<value>BBB</value>

<value>CCC</value>

</array>

</property>

<property name="mySet">

<list>

<value>AAA</value>

<value>BBB</value>

<value>CCC</value>

</list>

</property>

<property name="myMap">

<props>

<prop key="testC">ccc</prop>

<prop key="testD">ddd</prop>

</props>

</property>

<property name="myProps">

<map>

<entry key="testA" value="aaa"></entry>

<entry key="testB">

<value>BBB</value>

</entry>

</map>

</property>

</bean>

</beans>

注解IOC配置

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xmlns:context="http://www.springframework.org/schema/context"

xsi:schemaLocation="http://www.springframework.org/schema/beans

http://www.springframework.org/schema/beans/spring-beans.xsd

http://www.springframework.org/schema/context

http://www.springframework.org/schema/context/spring-context.xsd">

<!--告知spring在创建容器时要扫描的包,配置所需要的标签不是在beans的约束中,而是一个名称为

context名称空间和约束中-->

<context:component-scan base-package="cn.flyingd"></context:component-scan>

</beans>

注解知识点汇总

/**

* 账户的业务层实现类

*

* 曾经XML的配置:

* <bean id="accountService" class="cn.flyingd.service.impl.AccountServiceImpl" scope="" init-method="" destroy-method="">

* <property name="" value="" | ref=""></property>

* </bean>

*

* 用于创建对象的

* 他们的作用就和在XML配置文件中编写一个<bean>标签实现的功能是一样的

* Component:

* 作用:用于把当前类对象存入spring容器中

* 属性:

* value:用于指定bean的id。当我们不写时,它的默认值是当前类名,且首字母改小写。

* Controller:一般用在表现层

* Service:一般用在业务层

* Repository:一般用在持久层

* 以上三个注解他们的作用和属性与Component是一模一样。

* 他们三个是spring框架为我们提供明确的三层使用的注解,使我们的三层对象更加清晰

*

*

* 用于注入数据的

* 他们的作用就和在xml配置文件中的bean标签中写一个<property>标签的作用是一样的

* Autowired:

* 作用:自动按照类型注入。只要容器中有唯一的一个bean对象类型和要注入的变量类型匹配,就可以注入成功

* 如果ioc容器中没有任何bean的类型和要注入的变量类型匹配,则报错。

* 如果Ioc容器中有多个类型匹配时:

* 出现位置:

* 可以是变量上,也可以是方法上

* 细节:

* 在使用注解注入时,set方法就不是必须的了。

* Qualifier:

* 作用:在按照类中注入的基础之上再按照名称注入。它在给类成员注入时不能单独使用。但是在给方法参数注入时可以(稍后我们讲)

* 属性:

* value:用于指定注入bean的id。

* Resource

* 作用:直接按照bean的id注入。它可以独立使用

* 属性:

* name:用于指定bean的id。

* 以上三个注入都只能注入其他bean类型的数据,而基本类型和String类型无法使用上述注解实现。

* 另外,集合类型的注入只能通过XML来实现。

*

* Value

* 作用:用于注入基本类型和String类型的数据

* 属性:

* value:用于指定数据的值。它可以使用spring中SpEL(也就是spring的el表达式)

* SpEL的写法:${表达式}

*

* 用于改变作用范围的

* 他们的作用就和在bean标签中使用scope属性实现的功能是一样的

* Scope

* 作用:用于指定bean的作用范围

* 属性:

* value:指定范围的取值。常用取值:singleton prototype

*

* 和生命周期相关 了解

* 他们的作用就和在bean标签中使用init-method和destroy-methode的作用是一样的

* PreDestroy

* 作用:用于指定销毁方法

* PostConstruct

* 作用:用于指定初始化方法

*/

spring自定义配置类

/**

* 该类是一个配置类,它的作用和bean.xml是一样的

* spring中的新注解

* Configuration

* 作用:指定当前类是一个配置类

* 细节:当配置类作为AnnotationConfigApplicationContext对象创建的参数时,该注解可以不写。

* ComponentScan

* 作用:用于通过注解指定spring在创建容器时要扫描的包

* 属性:

* value:它和basePackages的作用是一样的,都是用于指定创建容器时要扫描的包。

* 我们使用此注解就等同于在xml中配置了:

* <context:component-scan base-package="cn.flyingd"></context:component-scan>

* Bean

* 作用:用于把当前方法的返回值作为bean对象存入spring的ioc容器中

* 属性:

* name:用于指定bean的id。当不写时,默认值是当前方法的名称

* 细节:

* 当我们使用注解配置方法时,如果方法有参数,spring框架会去容器中查找有没有可用的bean对象。

* 查找的方式和Autowired注解的作用是一样的

* Import

* 作用:用于导入其他的配置类

* 属性:

* value:用于指定其他配置类的字节码。

* 当我们使用Import的注解之后,有Import注解的类就父配置类,而导入的都是子配置类

* PropertySource

* 作用:用于指定properties文件的位置

* 属性:

* value:指定文件的名称和路径。

* 关键字:classpath,表示类路径下

*/

//@Configuration

@ComponentScan("cn.flyingd")

@Import(JdbcConfig.class)

@PropertySource("classpath:jdbcConfig.properties")

public class SpringConfiguration {

}

Spring整合junit的配置

/**

* 使用Junit单元测试:测试我们的配置

* Spring整合junit的配置

* 1、导入spring整合junit的jar(坐标)

* 2、使用Junit提供的一个注解把原有的main方法替换了,替换成spring提供的

* @Runwith

* 3、告知spring的运行器,spring和ioc创建是基于xml还是注解的,并且说明位置

* @ContextConfiguration

* locations:指定xml文件的位置,加上classpath关键字,表示在类路径下

* classes:指定注解类所在地位置

*

* 当我们使用spring 5.x版本的时候,要求junit的jar必须是4.12及以上

*/

@RunWith(SpringJUnit4ClassRunner.class)

@ContextConfiguration(classes = SpringConfiguration.class)

public class AccountServiceTest {

@Autowired

private IAccountService as = null;

@Test

public void testFindAll() {

//3.执行方法

List<Account> accounts = as.findAllAccount();

for(Account account : accounts){

System.out.println(account);

}

}

}

_posts/2018-08-02-Java-MySQL的相关配置.md������������������������������������������������������0000664�0001750�0001750�00000022551�14131047130�022737� 0����������������������������������������������������������������������������������������������������ustar �wangwen�������������������������wangwen����������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������������— layout: post title: Java实现MySQL的相关配置 subtitle: MySQL date: 2018-08-02 author: AnAn header-img: /img/post-bg-article.jpg catalog: true tags: - Java - MySQL —

- DML(data manipulation language): 它们是SELECT、UPDATE、INSERT、DELETE,就象它的名字一样,这4条命令是用来对数据库里的数据进行操作的语言

- DDL(data definition language): DDL比DML要多,主要的命令有CREATE、ALTER、DROP等,DDL主要是用在定义或改变表(TABLE)的结构,数据类型,表之间的链接和约束等初始化工作上,他们大多在建立表时使用

- DCL(Data Control Language): 是数据库控制功能。是用来设置或更改数据库用户或角色权限的语句,包括(grant,deny,revoke等)语句。在默认状态下,只有sysadmin,dbcreator,db_owner或db_securityadmin等人员才有权力执行DCL

Mysql常用命令

- mysql 初始化时修改密码

alert user user() identified by "密码";SqlMapConfig.xml

```xml <?xml version=”1.0” encoding=”UTF-8”?> <!DOCTYPE configuration PUBLIC “-//mybatis.org//DTD Config 3.0//EN” “http://mybatis.org/dtd/mybatis-3-config.dtd”>

### jdbcConfig.properties

```properties

jdbc.driver=com.mysql.jdbc.Driver

jdbc.url=jdbc:mysql://localhost:3306/eesy_mybatis

jdbc.username=root

jdbc.password=1234

映射文件XxxDao.xml

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE mapper

PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN"

"http://mybatis.org/dtd/mybatis-3-mapper.dtd">

<mapper namespace="com.xxx.dao.IUserDao">

<!-- 查询所有 -->

<select id="findAll" resultType="com.xxx.domain.User">

select * from user;

</select>

<!-- 保存用户 -->

<insert id="saveUser" parameterType="com.xxx.domain.User">

<!-- 配置插入操作后,获取插入数据的id -->

<selectKey keyProperty="id" keyColumn="id" resultType="int" order="AFTER">

select last_insert_id();

</selectKey>

insert into user(username,address,sex,birthday)values(#{username},#{address},#{sex},#{birthday});

</insert>

<!-- 更新用户 -->

<update id="updateUser" parameterType="com.xxx.domain.User">

update user set username=#{username},address=#{address},sex=#{sex},birthday=#{birthday} where id=#{id}

</update>

<!-- 删除用户-->

<delete id="deleteUser" parameterType="java.lang.Integer">

delete from user where id = #{uid}

</delete>

<!-- 根据id查询用户 -->

<select id="findById" parameterType="INT" resultType="com.xxx.domain.User">

select * from user where id = #{uid}

</select>

<!-- 根据名称模糊查询 -->

<select id="findByName" parameterType="string" resultType="com.xxx.domain.User">

select * from user where username like #{name}

</select>

<!-- 获取用户的总记录条数 -->

<select id="findTotal" resultType="int">

select count(id) from user;

</select>

</mapper>

mybatis入门案例

- mybatis-config.xml ```xml

<?xml version=”1.0” encoding=”UTF-8”?> <!DOCTYPE configuration PUBLIC “-//mybatis.org//DTD Config 3.0//EN” “http://mybatis.org/dtd/mybatis-3-config.dtd”>

- xxMapper.xml

```xml

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE mapper

PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN"

"http://mybatis.org/dtd/mybatis-3-mapper.dtd">

public class MybatisTest {

/**

* 入门案例

* @param args

*/

public static void main(String[] args)throws Exception {

//1.读取配置文件

InputStream in = Resources.getResourceAsStream("SqlMapConfig.xml");

//2.创建SqlSessionFactory工厂

SqlSessionFactoryBuilder builder = new SqlSessionFactoryBuilder();

SqlSessionFactory factory = builder.build(in);

//3.使用工厂生产SqlSession对象

SqlSession session = factory.openSession();

//4.使用SqlSession创建Dao接口的代理对象

IUserDao userDao = session.getMapper(IUserDao.class);

//5.使用代理对象执行方法

List<User> users = userDao.findAll();

for(User user : users){

System.out.println(user);

}

//6.释放资源

session.close();

in.close();

}

}

mybatis复杂条件查询

<select id="findUserByCondition" resultMap="userMap" parameterType="user">

select * from user

<where>

<if test="userName != null">

and username = #{username}

</if>

<if test="userSex != null">

and sex = #{sex}

</if>

</where>

</select>

<!-- 根据queryvo中的Id集合实现查询用户列表 -->

<select id="findUserInIds" resultMap="userMap" parameterType="queryvo">

<include refid="defaultUser"></include>

<where>

<if test="ids != null and ids.size()>0">

<foreach collection="ids" open="and id in (" close=")" item="uid" separator=",">

#{uid}

</foreach>

</if>

</where>

</select>

mybatis一对一查询

<!-- 定义封装account和user的resultMap -->

<resultMap id="accountUserMap" type="account">

<id property="id" column="aid"></id>

<result property="uid" column="uid"></result>

<result property="money" column="money"></result>

<!-- 一对一的关系映射:配置封装user的内容-->

<association property="user" column="uid" javaType="user">